Çok Katmanlı Algılayıcılar

Dr. Hidayet Takçı

htakci@gmail.com | http://htakci.sucati.org

Perceptron Sınıflandırması

Perceptronlar sadece doğrusal sınıflandırma yapabilir.

2

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

ÇKA ile Sınıflandırma

Konveks Alanların Birleşimi

3

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Çok Katmanlı Algılayıcılar

Gerçek hayatta birçok problem doğrusal olmayan yapıdadır. Çok

katmanlı algılayıcılar doğrusal olmayan problemlerin çözümünde

en sık kullanılanYSA modelidir.

ÇKA için en popüler ağ yapısı Back Propagation (geriye yayılım)

ağıdır.

• Back Propagation ağı, ilk kez 1974 yılında Werbos tarafından

önerilmiştir, şu anda kullanılan versiyon 1986 yılında Rumelhart,

Hinton, ve Williams tarafından geliştirilmiştir.

4

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri Yayılımlı Öğrenim

Mimari :

En az üç katmandan meydana gelen, ileri beslemeli, geri yayılımlı ağ

Düğüm fonksiyonu (türevi alınabilecek) herhangi bir fonksiyon

olabilir fakat en sık tercih edileni: sigmoid function

Öğrenim :

Genelleştirilmiş delta kuralı

Ağırlık güncelleme kuralı :

gradient descent (eğim düşümü)

5

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

6

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri Yayılımlı Öğrenim

Ağırlıklar :

w(1,0)giriş katmanından gizli katmana ağırlık

w( 2,1)gizli katmandan çıkış katmanına ağırlık

w2(1,1,0)giriş katmanındaki düğüm 1 den gizli katmandaki düğüm 2 ye

ağırlık

Eğitim örnekleri: {( x p , d p ) p = 1,..., P}

şeklinde verilir ve bu örnekler ile denetimli öğrenim yapılır.

Giriş örüntüsü:

x p = ( x p ,1 ,..., x p ,n )

Çıkış örüntüsü:

o p = (o p ,1 ,..., o p ,k )

d p = (d p ,1 ,..., d p ,k )

Hata: l p , j = o p , j − d px,pj uygulandığı zaman çıktı j için hataların

kareleri toplamı

Beklenen çıktı:

P

K

= ∑∑ (l p , j ) 2

p =1 j =1

7

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri Yayılımlı Öğrenim

Yeniden Sigmoid fonksiyonu:

Fonksiyonun türevi:

1

1 + e−x

1

−x

S ' ( x) = −

e

⋅

(

1

+

)'

−x 2

(1 + e )

1

−x

=−

⋅

(

−

e

)

−x 2

(1 + e )

1

e− x

=

⋅

−x

1 + e 1 + e−x

S ( x) =

= S ( x)(1 − S ( x))

zincir kuralı

8

dz dz dy dx

if z = f ( y ), y = g ( x), x = h(t ) then = ⋅ ⋅ = f ' ( y ) g ' ( x)h' (t )

dy dx dt

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçıdt

Geri Yayılımlı Öğrenim

Đleriye doğru hesaplama:

Bir x giriş vektörü giriş düğümlerine uygulanır

Gizli katmandaki x(1) çıkış vektörü hesaplanır

x (j1) = S (net (j1) ) = S (∑ w(j1,i,0) xi )

i

Çıktı katmanında çıkış vektörü o hesaplanır

ok = S (netk( 2) ) = S (∑ wk( 2, ,j1) x (j1) )

j

net, x giriş vektöründen o çıkış vektörüne bir eşleştirmeyi ifade eder

Öğrenmenin amacı:

Hataların kareleri toplamını azaltmak,

P K

∑ ∑ (l p, j ) 2

p =1kadar

j =1

verilen eğitim örnekleri için mümkün olabildiği

iyi sonuçları elde

etmek (eğer olabiliyorsa sıfır hata)

9

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri Yayılımlı Öğrenim

BP öğrenimin çalışması:

Delta kuralı yardımıyla; katman 1’den katman 2’ye ağırlıklar

(w(2,1)) güncellenir.

Fakat delta kuralı w(1,0) ağırlıklarını güncelleme için uygun

değildir, çünkü gizli düğümler için belirlenen değerler

bilinmemektedir.

Çözüm: Çıkış düğümündeki hataların gizli düğümlere

yayılımı sayesinde, gizli düğümlerde hesap edilen

ağırlıkların w(1, 0) güncellenmesi sağlanır ve bu hataların

geriye yayılımı olarak isimlendirilir.

Gizli düğümlerdeki hataların nasıl hesap edildiği anahtar

konulardan biridir.

10

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri Yayılımlı Öğrenim

Genelleştirilmiş delta kuralı:

(xp, dp) örneği için sıralı bir öğrenim modu varsayalım

E = ∑k (l p ,k ) 2

Ağırlıklar eğim düşümü (gradient descent) ile güncellenir

w(2, 1) ağırlığı için :

∆wk( 2, ,j1) ∝ (−∂E / ∂wk( 2, ,j1) )

w(1, 0) ağırlığı için :

∆w(j1,i,0) ∝ (−∂E / ∂w(j1,i,0) )

w(2, 1) için güncelleme kuralının türetimi :

E, lk = dk – ok ‘nin bir fonksiyonu, dk – ok ,

,

11

( 2,1)

( 2)

‘nin bir fonksiyonu

w

olduğu

için

net k

k, j

Yukarıdaki zincir kuralını yazabiliriz.

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

2 ) fonksiyonu ve

‘nin

net k(bir

Geri Yayılımlı Öğrenim

(1, 0 )

w

j ,i için

ok

güncelleme kuralının türetimi

wk( 2, ,j1)

düğüm j gizli düğüm olsun:

(1)

w(j1,i,0) ağırlığı net jdeğerini etkiler

)

bütün çıkış düğümlerine S (net (j1değeri

gönderilir

)

∴ E deki bütün K terimleri

j

w(j1,i,0)

,0)

bir fonksiyonudur

w(j1‘nin

,i

i

E = ∑ k ( d k − ok ) 2 , ok = S ( net k( 2 ) ), net k( 2 ) = ∑ j x (j1) wk( 2, ,j1) ,

x (j1) = S ( net (j1) ), net (j1) = ∑i xi w (j1,i, 0 )

zincir

kuralı ile

12

∂E

∂ok

∂S (netk( 2) )

∂netk( 2)

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

∂netk( 2)

∂x (j1)

∂x (j1)

∂net (j1)

∂net (j1)

∂w(j1,i)

Geri Yayılımlı Öğrenim

Güncelleme kuralları:

harici katman ağırlıkları w(2, 1) için :

where

δ k = (d k − ok ) S ' (netk( 2) )

dahili katman ağırlıkları w(1, 0) için :

burada µ j = (∑k δ k wk( 2, ,j1) ) S ' ( net (j1) )

13

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Çıkış katmanından

hataların ağırlıklı

toplamı

Detaylar

x=giri

x=girişş de

değ

ğerleri, y=çıkış

y=çıkış de

değğerleri olmak üzere eğ

eğitim

verisi;

(x1,t1),(x2,t2),……,(xp

(x1,t1),(x2,t2),……,(

xp,,tp

tp))

Net giriş

giriş de

değ

ğerleri aş

aşağıdaki gibidir.

kth çıkı

çıkışş tabakasındaki herhangi bir nörondaki hata, e=

e=ttk-

değ

ğeri)'

eri)'dir

dir.. Burada tk=olması gereken çıktı,

ok (Hata de

ok=fiili çıktıdır.

14

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Delta Kuralı tarafından minimize edilmi

edilmişş toplam hata

hata::

Bu algoritma ile i. ve j. katman işlem elemanları arasındaki

ağırlıklardaki wji(t) de

değğişikliğ

ikliği hesaplanır

hesaplanır..

η(Ö

(Öğğrenme katsayısı), α(momentum katsayısı) ve δ ise (j ara veya

çıkış katındaki herhangi bir j nöronuna ait bir faktördür)

çıkış

faktördür).. Buradaki

∆wij ağırlık farkıdır

farkıdır..

15

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

j (gizli katman) ve k (çıkış

(çıkış katmanı) düğ

düğümleri için çıkış

çıkış de

değğerleri

şu şekilde hesaplanır;

Çıkı

Çıkışş tabakasında bütün düğ

düğümler için eğ

eğitme esnasında

denklemden hesaplanan bir hata değ

değeri;

16

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

De

Değğerler hesaplandıktan sonraki adım, backpropagation ba

başşlama

adımıdır.

17

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

18

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri Yayılımlı Öğrenim(güçlü yönleri)

Güçlü sunum yeteneği

Herhangi bir L2 fonksiyonu (kare alma, integral ve diğer matematiksel

fonksiyonlar) BP ağı ile sunulabilir

Böylesi birçok fonksiyon BP öğrenimi ile yakınsayabilir (gradient

descent yaklaşımı)

Geniş kullanım alanı

Yalnızca kullanılabilir eğitim örneklerinin bir kümesine ihtiyaç duyar

Çalışma alanının derin şekilde anlaşılması veya kısmi bir ön bilgiye

ihtiyaç duymaz (yapısı iyi olmayan problemleri çözebilir – ill posed)

Eğitim örneklerinde gürültü ve kayıp değerleri tolere eder

Đyi genelleştirme yeteneği vardır

Eğitim kümesi dışındaki girişler için sıklıkla doğru sonuçları

üretir

19

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

BP Öğrenimin Kusurları

Öğrenim sıklıkla uzun zaman alır

Karmaşık fonksiyonlar yüzlerce hatta binlerce çevrim sürer

Ağ aslında bir kara kutudur.

Giriş ve çıkış vektörleri (x, o) arasında belirlenen bir haritalama

sağlayabilir ama neden bir kısım x değerinin bir kısım o ile

eşleştirildiği bilgisini sunamaz.

Bunun sebebi gizli düğümler ve öğrenilen ağırlıkların açık anlamlara sahip

olmamasıdır.

Birçok istatistiksel modelin aksine teorik olarak BP

öğrenimin bulduğu sonuçların kalitesi ile ilgili bir sonuç

verilemez.

Eğitilen bir BP ağı için güvenilirlik seviyesi nedir?

20

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Gradient descent yaklaşımı ile ilgili problem

Toplam hatanın sadece yerel minimuma indirilmesi garanti edilir, E

(hata) sıfır değerine indirilemeyebilir

Hata yüzeyinin şekli önemlidir. Yüzey üzerindeki yerel minimum

noktalarından herhangi birine düşme ihtimali yüksektir.

Olası çareler:

Farklı sayıda gizli düğüm ve gizli katman kullanılabilir (onlar farklı

hata yüzeylerini oluşturacaktır, bazıları diğerlerinden daha iyi

olabilir)

Farklı başlangıç değerleri verilebilir (yüzey üzerinde farklı başlama

noktaları)

21

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Eğitim seti için hata sıfıra düşürüldüğümde Genelleştirme

garanti edilemez.

Over-fitting/over-training problemi: eğitilen ağ eğitim

örneklerini mükemmel olarak uygunlaştırır fakat test setindeki

örneklerde doğru sonuçlar vermeyebilir

– Olası çareler:

• Daha çok ve daha iyi örnekler

• Mümkünse daha küçük ağ kullanımı

• Daha büyük hata sınırı kullanımı (erken

sonlandırma)

• Örneklere katsayılar eklenir

– (x1,…, xn) to (x1α1,…, xn αn)

• Çapraz doğrulama

– Örneklerin bir kısmını (~10%) test verisi olarak kullan (ağırlık

güncelleme için kullanma)

– Yapay

TestSinir

verisi

üzerinde

periyodik

hata kontrolleri

Ağları

ve

Uygulamaları

Hidayet

Takçı

22

– Test verisi üzerindeki hata artmaya başladığında öğrenimi durdur

Pratik Hususlar

Đyi bir BP ağı öğrenim algoritmalarından daha fazlasına ihtiyaç duyar.

Đyi bir performans için birçok parametre dikkatli şekilde seçilmelidir.

BP ağlarının kusurları olmasına rağmen bazı pratik yöntemler ile

problemler azaltılabilir.

Başlangıç ağırlıkları (ve bias değerleri)

Rastgele, [-0.05, 0.05], [-0.1, 0.1], [-1, 1]

Gizli katman için ağırlıklar normalleştirilir (w(1, 0))

Bütün gizli düğümler için başlangıç ağırlıkları atanır

Her bir j gizli düğümü kendi ağırlığı ile normalleştirilir

w(j1,i,0) = β ⋅ w(j1,i,0) / w(j1,0)

2

where β = 0.7 n m

m = # of hiddent nodes, n = # of input nodes

23

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Ne kadar katman ve her katmanda ne kadar gizli

düğüm olmalı?

Teorik olarak, L2 fonksiyonları için bir gizli katman (birçok gizli

düğüm ile) yeterlidir

Gizli katmanların kaç tane olması ile ilgili teorik bir bilgi yoktur

Pratik kural:

n = # giriş düğümleri; m = # gizli düğümler

Unipolar/bipolar veri için: m = 2n

Real veri için : m >> 2n

Bazı uygulamalarda benzer kalite için daha az sayıda düğüm ile işlem

yerine getirilebilir ve az sayıda düğüm daha hızlı eğitilebilir.

24

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Eğitim örnekleri:

Öğrenim sonuçlarının kalitesini eğitim örneklerinin kalitesi ve

miktarı belirler

Örnekler bütün problem uzayını toplu olarak sunabilmelidir

Rastgele örnekleme

Parçalı örnekleme (problem uzayı hakkında ön bilgi ile)

# ihtiyaç duyulan örüntü adedi : Teorik olarak bu konuda ideal

bir değer yoktur.

Baum and Haussler (1989): P = W/e,

W: eğitim için gerekli ağırlıkların toplam adedi (ağ yapısına bağlı)

e: kabul edilebilir sınıflandırma hatası

Örnek: W = 27, e = 0.05, P = 540. Eğer biz doğru sınıflandırma

yapan ağı başarı ile eğitmişsek (1 – 0.05/2)*540 = 526 örnek, ağ

diğer girişleri %95 doğrulukla sınıflandıracaktır.

25

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Data representation:

unipolar (0,1) ve bipolar (-1,1)

Bipolar sunum eğitim örneklerini daha etkin kullanır

∆w(j1,i,0) = η ⋅ µ j ⋅ xi

∆wk( 2, ,j1) = η ⋅ δ k ⋅ x (j1) xi = 0 or x (j1) = 0

eğer ikili sunum olsa idi eğitim olamayacaktı

n giriş düğümü ile için örüntülerin adedi : unipolar: 2^

bipolar: eğer bias kullanılmazsa 2^(n-1)

Gerçel değerli veri

Giriş düğümleri: gerçel değerli düğümler (normalleştirme gerekebilir)

Gizli düğümler için çıkış fonksiyonu sigmoid

Çıkış düğümleri için sıklıkla doğrusal (hatta identity)

Eğitim unipolar/bipolar veriden daha yavaş olabilir (bazen gerçel

değerlerin ikili kodlaması kullanılır)

ok = ∑ wk( 2, ,j1) x (j1)

26

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Öğrenme Katsayısı (η

(η)

•

Öğrenme katsayısı ağırlıkların değişim miktarını belirler.

E

E

W

Eğer öğrenme katsayısı gereğinden büyük olursa

problem uzayında rasgele gezinme olur. Bunun

da ağırlıkları rasgele değiştirmekten farkı olmaz.

27

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

W

Eğer öğrenme katsayısı çok küçük olursa çözüme

ulaşmak daha uzun sürer.

Öğrenme Katsayısı η

Sabit olarak 1 değerinden çok daha küçüktür

Büyük η ile başlanır ve dereceli olarak değeri düşürülür

Küçük η ile başlanır hata artmaya başlayana kadar büyütülür

Öğrenimin her bir aşamasında maksimum güvenli adım bulunur

(öğrenim oranı büyürken hatanın minimumda kalmasına çalışılır)

Adaptif Öğrenme Katsayısı (delta-bar-delta method)

Herbir wk,j ağırlığın kendine ait bir ηk,j öğrenim oranı vardır

Eğer

aynı yönde kalırsa, ηk,j artırılır (geçerli w değerinin

çevresinde E için bir düzgün eğri vardır)

Eğer ∆wk , j

yönü değişirse, ηk,j azaltılır (geçerli w değerinin

çevresinde E için bir düzgün olmayan eğri vardır)

∆wk , j

28

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Momentum Katsayısı (α

(α)

E

Yerel

Minimum

Plato

Momentum katsayısı, yerel çözümlere

ve platolara takılmayı önler.

Global

Minimum

Bu değerin çok küçük seçilmesi yerel

çözümlerden kurtulmayı zorlaştırır.

Değerin çok büyük seçilmesi ise tek bir

çözüme ulaşmada sorunlar yaratabilir.

W

29

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

∂E

∆w(t + 1) = −η

+ α∆w(t )

∂wij

BP ağlarının çeşitleri

Momentum terimi eklenerek (öğrenmeyi hızlandırmak için)

t+1 anında ağırlıkların güncellenmesi önceki güncellemelerin

momentumunu içerir, örn.,

∆wk , j (t + 1) = η ⋅ δ k (t ) ⋅ x j + α ⋅ ∆wk , j (t )

Ağırlık güncellemenin ani değişimlerinden kaçınmak mümkündür

(öğrenim işleminin düzgünleştirilmesi)

Hata monotonik olarak azalır

Ağırlık güncellemelerini toplu modu

Herbir epoch için birkez ağırlık güncellenir (bütün P tane örnek için

toplu güncelleme)

Öğrenim örnek sunumların sırasından bağımsızdır

Sıralı moddan genellikle daha yavaştır

30

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Durdurma KriterleriHata

Hatanın belli bir değerin

altına düşmesi sonucu

durma

ε

Đterasyon

Hata

Belirli sayıda

iterasyondan sonra

durma

t

31

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Đterasyon

Ağın Ezberlemesi (Overfitting)

Burada

Hata

durdurulması

gerekir

Test

Seti Hatası

Öğrenme

Seti Hatası

Đterasyon

Ağ gereğinden fazla eğitilirse problemi öğrenmek yerine

verileri ezberler. Bu da ağın genelleme yapamamasını ve

hatalı sonuçlar üretmesine neden olur.

32

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Uygulama Alanları

Hemen hemen her alanda örnekleri görülen bir

modeldir.

Genel Olarak;

Sınıflandırma

Tahmin etme

Tanıma

Yorum yapma

Teşhis etme alanlarında başarı ile kullanılmaktadır.

33

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri yayılımlı öğrenim

Örüntü sınıflandırma:

Đki sınıf: 1 çıkış düğümü

N sınıf: ikili kodlama (log N) çıkış düğümü

34

N çıkış düğümü kullanılırken bir sınıf daha iyi şu şekilde sunulabilir

(0,..., 0,1, 0,.., 0)

Sigmoid fonksiyonu kullanıldığında çıkış katmanındaki düğümler asla 1

veya 0 olmayacaktır onun yerine 1 – ε veya ε olacaktır.

Doygunluk noktalarında hata azaltma daha yavaş hale gelecektir (ε küçük

olduğunda).

Hızlı öğrenim için, verilen bir ε sınırı için,

eğer |dp,k – op,k| ≤ ε ise hata lp,k = 0 şeklinde set edilir.

Bir x girişi eğitilmiş bir BP ağı kullanarak sınıflandırılacağı zaman, eğer

bütün l != k için dk. > dl ise giriş kth sınıfa atanır.

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri yayılımlı öğrenim

Örüntü sınıflandırma: bir örnek

myoelectric sinyallerinin sınıflandırılması

Giriş örüntüsü: 3 özellik (NIF, VT, RR), 0 ile 1 arasında gerçek değerlere

normalize edilir

Çıkış örüntüleri: 2 sınıf: (başarılı, hatalı)

Ağ yapısı : 2-5-3

3 giriş düğümü, 2 çıkış düğümü

5 düğümlü 1 gizli katman

η = 0.95, α = 0.4 (momentum)

Hata sınırı ε = 0.05

332 eğitim örneği

Maksimum iterasyon sayısı = 20,000

Durduğu zaman, 38 örüntünün hatalı sınıflandırıldığı anlaşılmıştır.

35

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Geri yayılımlı öğrenim

Fonksiyon yakınsama:

Verilen w = (w(1, 0), w(2,1)), o = f(x) için: f ‘den bir fonksiyonel haritalama elde

edilir.

Teorik olarak, doğrusal olmayan düğümlerin en az bir gizli katmanına sahip olan

ileribeslemeli ağlar L2 formunda (bütün kare integral fonksiyonları ve hemen

hemen genel olarak kullanılan bütün matematik fonksiyonları) herhangi bir

fonksiyona yakınsayabilir.

Herhangi bir L2 fonksiyonu f (x) bir Fourier serisi tarafından yakınsanır

Fourier serileri cosine düğüm fonksiyonunun bir gizli katmanına sahip ileri

beslemeli bir ağ ile yakınsanabilir

36

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Applications of BP Nets

A simple example: Learning XOR

Başlangıç ağırlıkları ve diğer parametreler

weights: [-0.5, 0.5] arasında rastgele değerler

hidden nodes: 4 düğümlü tek katman (A 2-4-1 net)

biases used;

learning rate: 0.02

Çeşitleri test edildi

Unipolar ve bipolar sunum

Farklı durma kriterleri

Başlangıç değerleri normalleştirildi

(Nguyen-Widrow)

( targets

with ± 1.0 and with ± 0.8)

Bipolar, unipolar’dan daha hızlı

Unipolar için ~3000 epoch, bipolar için ~400 epoch

Why? (çünkü unipolar ile kimi zaman eğitim 0 değerlerinde yapılamıyor)

37

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Experimental comparison

Training for XOR problem (batch mode)

25 simulations with random initial weights: success if E averaged

over 50 consecutive epochs is less than 0.04

results

method

38

simulations

success

BP

25

24

16,859.8

BP with

momentum

25

25

2,056.3

BP with deltabar-delta

25

22

447.3

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Mean epochs

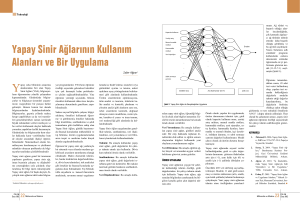

Data compression

Az sayıda gizli düğüm kullanımı ile örüntülerin kendi kendine

otomatik eşleştirmesi :

training samples:: x:x (x n boyutlu)

hidden nodes: m < n (A n-m-n net)

V

n

W

m

n

Eğer eğitim başarılı ise, herhangi bir x vektörü giriş düğümüne

uygulanarak çıkış düğümünde aynı x değeri üretilecektir

Gizli katmandaki z örüntüsü x’in sıkıştırılmış bir sunumu haline

gelecektir (with smaller dimension m < n)

Uygulama: iletim maliyetinin düşürülmesi

x

39

n

V

m

z

z

m

W

Communication

Yapay Sinir Ağları ve Uygulamaları - Hidayet

Takçı

sender

channel

receiver

n

x

Example: karakter resimlerinin sıkıştırılması

Herbir karakter 7 x 9 pixel bitmap veya 63 boyutlu bir ikili vektör ile

sunulabilir

Deneyde 10 characters (A – J) kullanılmıştır

Hata oranı:

tight(sıkı): 0.1 (off: 0 – 0.1; on: 0.9 – 1.0)

loose(serbest): 0.2 (off: 0 – 0.2; on: 0.8 – 1.0)

Gizli düğümler, hata aralığı ve yakınsama oranı arasındaki ilişki

Hafif hata aralığı hızlanabilir

Gizli düğümlerin artırılması ile hız artabilir

error range: 0.1 hidden nodes: 10 # epochs 400+

error range: 0.2 hidden nodes: 10 # epochs 200+

error range: 0.1 hidden nodes: 20 # epochs 180+

error range: 0.2 hidden nodes: 20 # epochs 90+

22 üzerindeki gizli düğümlerde hız artımı farkedilebilir olmayabilir.

40

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Other applications.

Tıbbi teşhis

Input: belirtiler (semptomlar, lab testleri vs.)

Output: olası hastalıklar

Problemler:

Hiçbir nedensellik ilişkisi kurulamayabilir

Girişlerin ne olması gerektiğini belirlemek zordur

Aktif çalışmalar sınırlı tıbbi görevler üzerinde odaklanmıştır

Örn., standart kan testi tabanlı olarak hepatit B ve prostat

kanseri tahmini

Proses kontrol

Giriş: çevresel parametreler

Çıkış: kontrol parametreleri

Đyi yapılanmamış fonksiyonlar öğrenilebilir

41

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Stock market tahmini

Input: finansal faktörler (CPI (Customer Proximity Index), ilgi oranı, etc.)

ve önceki günlerin stok miktarları

Output: stok indisleri veya stok ücretlerinin tahmini

Training samples: geçen yıllara ait stok market verisi

Müşteri kredi değerlendirme

Input: kişisel finansal bilgi (gelir, alacak, vergi geçmişi, vs.)

Output: kredi puanı

Ve daha fazlası

Başarılı uygulamalar için anahtar

Giriş vektörünün dikkatli tasarımı (önemli büyün özelliklerin seçilmesi): bazı

domain bilgileri

Đyi eğitim örneklerinin elde edilmesi : zaman ve diğer maliyetler

42

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı

Önemli Not

Ders notlarının hazırlanmasında; başta Internet olmak

üzere çeşitli kaynaklardan faydalanılmış ve bize ait bir

son ürün ortaya konmuştur. Faydalandığımız kaynaklar

için herkese teşekkürler. Bu kaynağı değiştirmeden

kullanacakların ise referans göstererek çalışmamızı

kullanmalarında bir sakınca yoktur.

Dr. Hidayet Takçı

GYTE Bilgisayar Müh. Böl. Öğretim Elemanı

43

Yapay Sinir Ağları ve Uygulamaları - Hidayet Takçı