ANKARA ÜNİVERSİTESİ

FEN BİLİMLERİ ENSTİTÜSÜ

DOKTORA TEZİ

AKTÜERYAL MODELLEMEDE BULANIK DESTEK VEKTÖR

MAKİNELERİ

Furkan BAŞER

İSTATİSTİK ANABİLİM DALI

ANKARA

2013

Her hakkı saklıdır

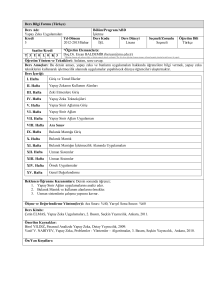

TEZ ONAYI

Furkan BAŞER tarafından hazırlanan “Aktüeryal Modellemede Bulanık Destek

Vektör Makineleri” adlı tez çalı

çalışması 22/07/2013 tarihinde aşağıdaki

ğıdaki jür

jüri tarafından

oy birliğii ile Ankara Üniversitesi Fen Bilimleri Enstitüsü İstatistik

statistik Ana

Anabilim Dalı’nda

DOKTORA TEZİ olarak kabul edilmiştir.

Danışman

: Prof. Dr. Ay

Ayşen APAYDIN

Jüri Üyeleri :

Başkan

: Prof. Dr. İ. Burhan TÜRKŞEN

TOBB Ekonomi ve T

Teknoloji Üniversitesi

Endüstri Mühendisliği Anabilim Dalı

Üye

: Prof. Dr. Ay

Ayşen APAYDIN

Ankara Üniversitesi, İstatistik Anabilim Dalı

Üye

: Prof. Dr. Burhan Ç

ÇİL

Gazi Üniversitesi, Ekonometri Anabilim Dalı

Üye

: Doç. Dr. Cemal ATAKAN

Ankara Üniversitesi, İstatistik Anabilim Dalı

Üye

: Doç. Dr. Fatih TANK

Ankara Üniversitesi, İstatistik Anabilim Dalı

Yukarıdaki sonucu onaylarım.

Prof. Dr. İbrahim

brahim DEMİR

DEM

Enstitü Müdürü

ÖZET

Doktora Tezi

AKTÜERYAL MODELLEMEDE BULANIK DESTEK VEKTÖR MAKİNELERİ

Ankara Üniversitesi

Fen Bilimleri Enstitüsü

İstatistik Anabilim Dalı

Danışman: Prof. Dr. Ayşen APAYDIN

Aktüerya bilimi, belirsizlik durumunda sigorta prim ve rezervlerini tespit etmek

amacıyla her türlü risk ölçüm ve hesaplamalarını kapsamaktadır. Bu belirsizlikler,

belirsiz ortamlarda optimum karar almaya yarayan ve belli bir mantığa dayalı çıkarım

olarak kabul edilen bulanık küme kuramı ile açıklanabilmektedir. Özellikle modelleme

problemlerinde optimum düzeyde belirsizliğe izin veren yöntemler geliştirmek

uygulamada büyük yarar sağlayacaktır. Çözümleme, öngörü ve denetim gibi alanlarda

farklı amaçlarla kullanılabilen bu yaklaşımların dayanıklılık ve şeffaflık gibi özellikleri

başlıca yararları arasındadır.

Yeni bir makine öğrenmesi tekniği olan destek vektör makineleri (DVM), fonksiyon

tahmini ve sınıflandırma problemlerinin çözümü için önerilmiş olan bir istatistiksel

öğrenme algoritmasıdır. Sinir ağları, bulanık modeller ve sinir-bulanık ortak sistemleri

gibi geleneksel öğrenme ve sistem modelleme yöntemleriyle karşılaştırıldığında, DVM

yüksek genelleme başarımı, en iyileme kapasitesi ve yüksek boyutlu az sayıda veri

üzerinde dahi çalışabilme gibi özelliklere sahiptir. Günümüzde DVM, veri

madenciliğinde, finans alanında, çeşitli mühendislik problemlerinde ve görüntü işleme

uygulamalarında başarıyla kullanılmaktadır.

Birçok problemde olduğu gibi sigorta problemlerinde de güvenilir modellerin

geliştirilmesi, sigorta şirketinin finansal istikrarı için çok önemlidir. Bu çalışmada, bazı

özel sigorta problemlerinde destek vektör makineleri ile (bulanık) regresyon

çözümlemesinin kullanımının önemi üzerinde durulacaktır. Bu doğrultuda, sistem

parametrelerinin optimizasyonu aracılığı ile gizli yapıları tanımlayabilen güçlü bulanık

modellere ulaşılması hedeflenmektedir.

Temmuz 2013, 154 sayfa

Anahtar Kelimeler: Bulanık sistem modelleri, bulanık regresyon, destek vektör

makineleri, ağırlıklı bulanık aritmetik, en küçük kareler prensibi, muallak hasar

rezervleri

i

ABSTRACT

Ph.D. Thesis

FUZZY SUPPORT VECTOR MACHINES IN ACTUARIAL MODELING

Ankara University

Graduate School of Natural and Applied Sciences

Department of Statistics

Supervisor: Prof. Dr. Ayşen APAYDIN

Actuarial science encompasses all types of quantifications of risks under conditions of

uncertainty for the purpose of setting insurance premiums and reserves. These

uncertainties can be explained well by fuzzy set theory which is accepted as an

inference mechanism based on certain logic and is useful for the optimal decisionmaking under uncertainty. Especially in modeling problems, developing methods that

allow an optimum level of uncertainty will be very beneficial in practice. These

methods can be used for different purposes in areas such as analyzing, prediction,

control, and the main benefits of them include features such as robustness and clearness.

A novel machine learning technique, Support Vector Machines (SVM), has recently

been receiving considerable attention in pattern recognition and regression function

estimation problems. Compared to the traditional learning and system modeling

methods such as neural networks, fuzzy models and neuro-fuzzy systems, SVM has a

high generalization performance, optimization capability, and can work even on highdimensional sparse data sets. Recently, SVM is successfully used in data mining,

various financial and engineering problems and image processing applications.

The development of reliable models for insurance problems as well as for the other

problems is very important for the financial stability of the insurance companies. In this

study, we intend to highlight the importance of the usage of (fuzzy) regression analysis

with support vector machines for some featured insurance problems. Accordingly, it is

aimed to achieve the strong fuzzy models that can identify hidden structures through

optimization of the system parameters.

July 2013, 154 pages

Key Words: Fuzzy system models, fuzzy regression, support vector machines,

weighted fuzzy arithmetic, the least squares principle, outstanding claim reserve

ii

TEŞEKKÜR

Tezin hazırlanması sırasında bilgi ve deneyimleri ile desteğini esirgemeyen danışman

hocam Sayın Prof. Dr. Ayşen APAYDIN (Ankara Üniversitesi, İstatistik Anabilim

Dalı)’a en içten teşekkürlerimi sunarım. Çalışmanın gelişimine önerileriyle önemli

katkılarda bulunan, tez izleme komitesi üyelerinden, Sayın Prof. Dr. İ. Burhan

TÜRKŞEN (TOBB Ekonomi ve Teknoloji Üniversitesi, Endüstri Mühendisliği

Anabilim Dalı)’e ve Sayın Doç. Dr. Cemal ATAKAN (Ankara Üniversitesi, İstatistik

Anabilim Dalı)’a teşekkürü bir borç bilirim. Gazi Üniversitesi’nde göreve başladığım

günden bu yana sevgi dolu yaklaşımı ile beni kendine hayran bırakan, bilime ve bilgiye

bakış açısı ile örnek aldığım değerli hocam Sayın Prof. Dr. Burhan ÇİL (Gazi

Üniversitesi, Ekonometri Anabilim Dalı)’e teşekkür ederim. Ayrıca, çalışmalarım

süresince birçok fedakârlıklar göstererek bana destek veren BAŞER ailesinin çok

değerli üyelerine sonsuz minnettarım.

Dünya bilim ve teknolojisine katkıda bulunan saygın bir Türkiye’nin yaratılması için

bilim insanlarına yönelik destekleyici ve teşvik edici bir program olan Bilim İnsanı

Destekleme Programı aracılığıyla; doktora öğrenimime destekte bulunan Türkiye

Bilimsel ve Teknolojik Araştırma Kurumu (TÜBİTAK)’na teşekkürlerimi sunarım.

Furkan BAŞER

Ankara, Temmuz 2013

iii

İÇİNDEKİLER

ÖZET ........................................................................................................................... i

ABSTRACT ............................................................................................................... ii

TEŞEKKÜR ............................................................................................................... iii

ŞEKİLLER DİZİNİ .................................................................................................. vii

ÇİZELGELER DİZİNİ ........................................................................................... viii

1. GİRİŞ VE ÖNCEKİ ÇALIŞMALAR .................................................................... 1

1.1 Giriş ...................................................................................................................... 1

1.2 Önceki Çalışmalar ................................................................................................ 3

2. İSTATİSTİKSEL ÖĞRENME TEORİSİ ............................................................. 8

2.1 Öğrenme Probleminin Yapısı .............................................................................. 8

2.1.1 Öğrenmenin amacı ............................................................................................ 9

2.1.2 Temel öğrenme problemleri ............................................................................ 10

2.1.3 Deneysel risk minimizasyonu .......................................................................... 11

2.2 Öğrenme Sürecinin Tutarlılığı Teorisi .............................................................. 15

2.2.1 Öğrenme teorisinin anahtar teoremi .............................................................. 16

2.2.2 Düzgün yakınsaklık için gerek ve yeter şartlar .............................................. 17

2.2.3 Öğrenme teorisinin üç aşaması ....................................................................... 21

2.3 Büyüme Fonksiyonu ve Vapnik–Chervonenkis Boyutu ................................... 23

2.3.1 Büyüme fonksiyonunun yapısı ........................................................................ 23

2.3.2 Vapnik–Chervonenkis boyutu ........................................................................ 25

2.4 Genelleme Üzerine Sınırlar ................................................................................ 27

2.4.1 Sınıflandırma ................................................................................................... 28

2.4.2 Regresyon ........................................................................................................ 31

2.5 Yapısal Risk Minimizasyonu ............................................................................. 32

3. DESTEK VEKTÖR MAKİNELERİ ................................................................... 36

3.1 Pay Tabanlı Kayıp Fonksiyonları ...................................................................... 39

3.2 Optimum Ayırma Hiperdüzlemi ....................................................................... 44

3.3 Çekirdek Gösterimi ile Nitelik Uzayları ............................................................ 54

3.3.1 Nitelik uzayında öğrenme ............................................................................... 55

3.3.2 Nitelik uzayına örtülü dönüşüm ..................................................................... 57

3.4 Doğrusal Olmayan Sınıflandırıcılar .................................................................. 60

3.5 Destek Vektör Makineleri ile Regresyon ........................................................... 61

3.5.1 Doğrusal regresyon ......................................................................................... 62

3.5.2 Doğrusal olmayan regresyon .......................................................................... 66

3.5.3 -Destek vektör regresyonu ............................................................................ 67

3.6 Toplam Hasar Ödeme Tutarlarının Kestiriminde DVR Yaklaşımı ................. 69

4. BULANIK REGRESYON FONKSİYONLARI YAKLAŞIMI ......................... 74

4.1 Bulanık Kümeleme Algoritmaları ..................................................................... 74

4.1.1 Bulanık c-ortalama kümeleme algoritması .................................................... 77

4.2 Bulanık Regresyon Fonksiyonları ..................................................................... 83

4.2.1 Bulanık regresyon fonksiyonları ile yapı tanımlama ..................................... 86

4.2.2 Bulanık regresyon fonksiyonları ile çıkarım .................................................. 91

4.3 Sigorta Hasar Tutarlarının Kestiriminde Bulanık Regresyon Fonksiyonları

Yaklaşımı ............................................................................................................ 93

5. MELEZ BULANIK DESTEK VEKTÖR REGRESYON ÇÖZÜMLEMESİ ... 99

5.1 Bulanık Sayılar ve Ağırlıklı Bulanık Aritmetik ................................................ 99

5.1.1 Bulanık kümeler ve temel kavramlar ............................................................. 99

5.1.2 Bulanık sayılar .............................................................................................. 101

5.1.3 Ağırlıklı bulanık aritmetik ............................................................................ 104

5.1.4 Bulanık sayıların ağırlıklı fonksiyonu .......................................................... 108

5.2 Melez Bulanık Destek Vektör Regresyonu ...................................................... 112

5.2.1 Bulanık doğrusal regresyon .......................................................................... 113

5.2.2 Bulanık doğrusal olmayan regresyon ........................................................... 116

5.3 Melez Bulanık DVR’nin Diğer Bazı Bulanık Regresyon Yöntemleri ile

Karşılaştırılması ................................................................................................ 118

6. SİGORTA HASAR REZERVLERİ ................................................................. 126

6.1 Geometrik Ayırma Yöntemi ............................................................................ 129

6.2 Sigorta Hasar Rezervlerinin Kestirimi için Önerilen Algoritma ................... 132

6.3 Melez Bulanık DVR ile Sigorta Hasar Rezervlerinin Kestirimi ..................... 135

7. SONUÇ VE TARTIŞMA ................................................................................... 140

KAYNAKLAR ....................................................................................................... 143

ÖZGEÇMİŞ ........................................................................................................... 151

ŞEKİLLER DİZİNİ

Şekil 2.1

Öğrenme makinesi modeli ......................................................................... 9

Şekil 2.2

DRM prensibinin tutarlılığı ...................................................................... 15

Şekil 2.3

Büyüme fonksiyonunun davranışı ............................................................ 24

Şekil 2.4

Gerçel değerli fonksiyonlar kümesinin VC boyutu ................................... 27

Şekil 2.5

Fonksiyonlar kümesinin yapısı ................................................................. 33

Şekil 2.6

değerinin ( sabit) bir fonksiyonu olarak gerçek (beklenen) risk ve

deneysel risk üzerine sınırlar .................................................................... 35

Şekil 3.1

Düzlemde üç nokta .................................................................................. 37

Şekil 3.2

Sınıflandırma için pay tabanlı kayıp ......................................................... 41

Şekil 3.3

Doğrusal ayrılabilir verilerin ikili sınıflandırması ..................................... 42

Şekil 3.4

Ayrılabilir olmayan verilerin ikili sınıflandırması .................................... 43

Şekil 3.5

Şekil 3.6

-duyarsız kayıp fonksiyonu .................................................................... 44

Optimum hiperdüzlemin karar sınırı ........................................................ 46

Şekil 3.7

Dual problemde optimum hiperdüzlem .................................................... 48

Şekil 3.8

Ayrılabilir olmayan veri durumunda optimum esnek pay hiperdüzlemi ..... 52

Şekil 3.9

Sınıflandırma probleminde nitelik dönüşümü ........................................... 56

Şekil 3.10 Doğrusal regresyon modelleri .................................................................. 71

Şekil 3.11 Polinomiyal regresyon modelleri ............................................................. 72

Şekil 4.1

Bulanık regresyon fonksiyonları yaklaşımı ile bulanık sistem modelleme . 85

Şekil 4.2

Küme geçerlilik göstergelerinin küme sayılarına göre değişimi ................ 95

Şekil 5.1

Üçgensel bulanık sayı ............................................................................ 102

Şekil 5.2

Yamuksal bulanık sayı ........................................................................... 104

Şekil 5.3

Bulanık fonksiyonlar ............................................................................. 108

Şekil 5.4

Düzenli fonksiyon .................................................................................. 109

Şekil 5.5

Düzenli olmayan fonksiyon ................................................................... 110

vii

ÇİZELGELER DİZİNİ

Çizelge 3.1 Klasik çekirdek fonksiyonları ................................................................ 60

Çizelge 3.2 Toplam hasar tutarlarının değişimi ........................................................ 70

Çizelge 3.3 Doğrusal ve doğrusal olmayan DVR çözümlemesi sonuçları ................. 73

Çizelge 4.1 Bazı uzaklık ölçüleri .............................................................................. 78

Çizelge 4.2 Bazı önemli küme geçerlilik göstergeleri ............................................... 82

Çizelge 4.3 Modelde yer alan girdi ve çıktı değişkenleri .......................................... 94

Çizelge 4.4 Hasar tutarlarının dağılımı ve betimleyici istatistikler ............................ 94

Çizelge 4.5 Küme geçerlilik göstergelerine göre optimum küme sayısı ve

bulanıklık derecesi ................................................................................. 95

Çizelge 4.6 Bulanık regresyon fonksiyonlarında en küçük kareler yöntemi

sonucunda elde edilen bulgular .............................................................. 97

Çizelge 4.7 Bulanık regresyon fonksiyonlarında klasik DVR yöntemi sonucunda

elde edilen bulgular ............................................................................... 97

Çizelge 4.8 Bulanık doğrusal regresyon fonksiyonlarında en küçük kareler

yöntemi sonucunda belirlenen katsayılar ............................................... 98

Çizelge 4.9 Bulanık doğrusal regresyon fonksiyonlarında DVR yöntemi

sonucunda belirlenen katsayılar ............................................................. 98

Çizelge 5.1 Kesin girdi – bulanık çıktı verisi .......................................................... 119

Çizelge 5.2 Kesin girdi – bulanık çıktı verisi ile çeşitli çekirdek fonksiyonları

için belirlenen değerleri ................................................................. 120

Çizelge 5.3 Simetrik üçgensel bulanık sayılar ile tanımlı bulanık girdi – çıktı

verisi .................................................................................................... 121

Çizelge 5.4 Simetrik üçgensel bulanık sayılar ile tanımlı bulanık girdi – çıktı

verisi için bulanık doğrusal regresyon modeline dayalı karşılaştırma

sonuçları .............................................................................................. 121

Çizelge 5.5 Simetrik üçgensel bulanık sayılar ile tanımlı bulanık girdi – çıktı

verisi için melez bulanık doğrusal olmayan DVR sonuçları ................. 121

Çizelge 5.6 Asimetrik üçgensel bulanık sayılar ile tanımlı bulanık girdi – çıktı

verisi .................................................................................................... 122

viii

Çizelge 5.7 Asimetrik üçgensel bulanık sayılar ile tanımlı bulanık girdi – çıktı

verisi için bulanık doğrusal regresyon modeline dayalı karşılaştırma

sonuçları ............................................................................................... 122

Çizelge 5.8 Asimetrik üçgensel bulanık sayılar ile tanımlı bulanık girdi – çıktı

verisi için melez bulanık doğrusal olmayan DVR sonuçları ................. 123

Çizelge 5.9 Ev değerlerine ilişkin kesin girdi – bulanık çıktı verileri ...................... 124

Çizelge 5.10 Ev değerleme modeli için bulanık doğrusal regresyon çözümlemesine

ilişkin karşılaştırma sonuçları .............................................................. 124

Çizelge 5.11 Ev değerleme modeli için melez bulanık doğrusal olmayan DVR

sonuçları .............................................................................................. 125

Çizelge 6.1 Hasar tutarları üçgeni .......................................................................... 129

Çizelge 6.2 Ortalama hasar tutarları üçgeni ............................................................ 130

Çizelge 6.3 Dört yıllık gelişme süreciyle hasar tutarları üçgeni .............................. 135

Çizelge 6.4 Uygulamaya ilişkin ortalama hasar tutarları (, ) üçgeni ..................... 136

Çizelge 6.5 ln , değerlerinden oluşan veri üçgeni ................................................ 136

Çizelge 6.6 ln ’nin en küçük kareler tahmini ve bulanıklaştırılmış katsayılar ....... 137

Çizelge 6.7 ln ’nin en küçük kareler tahmini ve bulanıklaştırılmış katsayılar .... 138

Çizelge 6.8 Hasar tutarlarına ilişkin kestirimler, ln , ........................................... 139

Çizelge 6.9 Hasar tutarlarına ilişkin kestirimler, S, ................................................ 139

Çizelge 6.10 Uygulamaya ilişkin muallak hasar tutarları .......................................... 139

ix

1. GİRİŞ VE ÖNCEKİ ÇALIŞMALAR

1.1 Giriş

Bilgi yüklü, karmaşık ve büyük veri setlerinin anlaşılmasına olan ihtiyaç; işletme, fen

ve mühendisliğin neredeyse tüm alanlarında yaygın hale gelmiştir. Bu örnekler, tıbbi

teşhis, el yazısı karakterlerin tanınması ve zaman serisi kestirimi gibi çeşitli problemleri

de içermektedir. İş dünyasında ise kurum veya müşteri verileri, stratejik bir servet

olarak görülmektedir. Bu veriler içerisinde saklı, faydalı bilginin ortaya çıkarılabilmesi

ve buna göre geliştirilen eylemler, günümüz rekabetçi dünyasında oldukça öneme

sahiptir.

Öğrenme yöntemi, mevcut veriden sistem girdileri ve çıktıları arasındaki bilinmeyen

eşleşmeyi (bağımlılık) açıklayan bir algoritmadır ve genellikle yazılımlar aracılığıyla

uygulanır. Bağımlılığı ortaya koyan doğru modelin belirlenmesiyle de girdi

değerlerinden sistem çıktıları kestirilir. Son yıllarda, makine öğrenmesi (machine

learning) alanında önemli gelişmeler gözlenmektedir. Bu durum,

•

düşük maliyetli bilgisayarların,

•

düşük maliyetli algılayıcıların ve veri tabanı teknolojilerinin,

•

bilgisayar eğitimli uygulama uzmanlarının

yaygınlaşmasından dolayı beklenilen bir gelişmedir (Cherkassky ve Mulier 2007).

Model geliştirme ve tahmini için yöntemler, istatistik (regresyon ve sınıflandırma),

mühendislik (örüntü tanıma) ve bilgisayar bilimi (yapay zeka, makine öğrenmesi ve veri

madenciliği) gibi alanlarda sıklıkla kullanılmaktadır. Veriden öğrenme için yapılan son

çalışmalar, yapay sinir ağları ve bulanık sistemler gibi biyolojik tabanlı yöntemlerin

geliştirilmesi ile sonuçlanmıştır.

1

Yıllar öncesinden araştırılmaya başlanmış olmasına rağmen belirsizlik halinde

modelleme problemi, henüz tamamıyla çözüme kavuşturulamamıştır (Türkşen 2009).

Diğer birçok problemde olduğu gibi sigorta problemlerinde de güvenilir modellerin

geliştirilmesi, model değişkenlerinin önemli değerlerinin tanımlanmasına bağlıdır.

Ancak gerçek hayat problemlerinde mevcut bilginin doğasından kaynaklı eksik olması,

belirsizlik ve hata içermesinden dolayı bu önemli değerler elde edilememektedir. Bu

çalışmanın amacı, mevcut bilginin muhafaza edilerek; belirsizliği parametrelerde ve

bulanık fonksiyonların yapısında tutmak üzere bir bulanık modelleme yapısı

geliştirmektir. Bu amaç doğrultusunda, sistem parametrelerinin optimizasyonu aracılığı

ile gizli yapıları tanımlayabilen güçlü bulanık modeller üzerinde durulacaktır.

Bu çalışmada, doğrusal veya doğrusal olmayan bulanık regresyon modelleri için melez

bulanık destek vektör regresyon çözümlemesi olarak adlandırılan yeni bir yöntem

geliştirilecektir. Önerilen yaklaşıma göre parametre tahminleri, klasik destek vektör

makineleri ve en küçük kareler prensibi temelindeki düşünceler kullanılarak doğrusal

kısıtlar ile tanımlı iki konveks karesel programlama probleminin çözümüyle

gerçekleştirilecektir. Ayrıca farklı çekirdek (kernel) fonksiyonlarının seçimi ile

polinomiyal regresyon fonksiyonları, radyal tabanlı fonksiyon formuna bağlı regresyon

fonksiyonları gibi doğrusal olmayan regresyon modelleri de elde edilecektir.

Çalışmanın ikinci bölümünde, istatistiksel öğrenme teorisine ilişkin temel kavramlar ele

alınacak ve sonuçlar incelenecektir. Esasında bu sonuçlar, regresyon ve sınıflandırma

amaçlı yapısal öğrenme yöntemlerinin anlaşılmasında gerekli kavramsal ve kuramsal

altyapıyı oluşturmaktadır.

Üçüncü bölümde, klasik destek vektör regresyonu tüm yönleri ile incelenecek; çekirdek

gösteriminden yararlanarak doğrusal olmayan destek vektör regresyon modeline ilişkin

programlama problemi ele alınacaktır. Ayrıca bu bölümde, -destek vektör regresyon

çözümlemesine de yer verilecektir. Bölümün uygulama kesiminde ise toplam hasar

ödeme tutarlarının kestiriminde destek vektör regresyon yaklaşımının önemi üzerinde

durulacaktır.

2

Dördüncü bölümde, Bulanık c-Ortalama Kümeleme Algoritması ele alınacak; Tip-1

Bulanık Regresyon Fonksiyonları ile bulanık sistem modelinin yapı tanımlama ve

çıkarım algoritmaları detaylı bir biçimde incelenecektir. Ayrıca, otomobil maddi zarar

sigortalama sürecinde, hasar tutarlarının kestirimi için Bulanık Regresyon Fonksiyonları

yaklaşımının bir uygulaması gerçekleştirilecektir.

Çalışmanın özgün kısmını oluşturan beşinci bölümünde, bulanık doğrusal ve doğrusal

olmayan regresyon modellerinde melez bulanık destek vektör regresyon çözümlemesi

tanıtılacaktır. Bulanık küme teorisi ve temel kavramlar ele alınacak; ağırlıklı bulanık

aritmetik tanımına göre asimetrik (simetrik) üçgensel bulanık sayılar için bulanık

aritmetik işlemler geliştirilecektir. Önerilen yöntemden elde edilen bulguları, literatürde

mevcut diğer bulanık destek vektör regresyon yöntemlerinden elde edilen bulgularla

karşılaştırabilmek amacıyla bu çalışmalarda kullanılan farklı veri setleri tekrar ele

alınacaktır.

Çalışmanın altıncı bölümünde, önerilen melez bulanık destek vektör regresyon yöntemi,

muallak hasar rezerv kestirimi olarak adlandırılan özel bir sigorta problemi üzerinde

uygulanacaktır. Bu nedenle, sigorta hasar rezervleri ve bazı temel kavramlar ele

alınacak; sigorta şirketinin hasar rezervi ayırma amaçları üzerinde durulacaktır. Daha

sonra, hasar rezerv kestiriminde melez bulanık destek vektör regresyonunun kullanımı

üzerine önerilen algoritma sunulacaktır.

Son olarak, uygulamalardan ulaşılan bulgular da değerlendirilerek çalışmadan elde

edilen önemli sonuçlar özetlenecektir.

1.2 Önceki Çalışmalar

Ölçüm kısıtları ve ölçüm hatalarının bir bileşimi olarak ortaya çıkan belirsizlik ile

neredeyse tüm gerçek dünya problemlerinde karşılaşılmaktadır. Bilişsel problemlerde

belirsizlik ise doğal dile özgü muğlaklık veya sosyal ilişkilerde insanların etkileşimi

3

sonucu beliren ortak anlamlılıktan kaynaklanmaktadır. Bundan dolayı; belirsizlik,

insanların gerçek dünya ile bir dereceden etkileşimi için gerekli bir kavramdır.

1965 yılında Prof. Lotfi A. Zadeh’in “Bulanık Kümeler” başlıklı yayını, modern

belirsizlik kavramının gelişiminde önemli bir dönüm noktası olarak kabul görmektedir.

Zadeh çalışmasında, kesin olmayan sınırlar ile tanımlanmış kümeler olarak açıkladığı

bulanık kümelere ilişkin bir teoriyi tanıtmıştır. Bulanık kümedeki üyeliklerin, kabul ya

da redden ziyade bir derecelendirme sonucu belirlenmesi bulanık kümelerin yegâne

özelliğidir (Zadeh 1965).

Bulanık sistem modellemesi, klasik matematiksel modellerin başarılı sonuçlar ortaya

çıkarmada yetersiz olduğu, karmaşık ve belirsiz sistemlerin modellenmesinde

kullanılmaktadır. Bilinen bulanık modeller, özellikle belirsizliğin hakim olduğu

sistemlerde kullanışlı olan bulanık kümelere ve bulanık mantığa dayalıdır. Bulanık

sistemlerin birçok bulanık modelinde kural tabanları, girdi ve çıktı değişkenleri için

tanımlanmış bulanık sözel terimlerin bulanık fonksiyonları ile birlikte kullanılmaktadır.

Bu modellerde, girdiler ve çıktılar arasındaki ilişkiler eğer-ise kuralları ile temsil

edilmektedir. Böylece farklı yapıları çözümlemek üzere geliştirilen bulanık çıkarım

sistemleri de farklılık göstermektedir (Celikyilmaz ve Türksen 2009).

Bulanık kural tabanları; bulanıklaştırma, bileşke (aggregation), durulaştırma gibi birçok

bulanık işlemciyi içermektedir. Bulanık kümelerin ve parametrelerinin tanımlanması,

üyelik fonksiyonlarının sayısının ve şeklinin belirlenmesi günümüzde birçok

araştırmacının odaklandığı bir konudur. Literatürde mevcut çeşitli bulanık sistem

modelleme yaklaşımları, belirsizliği çözümlemek üzere diğer esnek hesaplama

yaklaşımları ile birleştirilmiştir. Yapısal olarak bulanık sistemleri kurmak için tek bir

çözüm olarak değerlendirilmemesi gereken bu yaklaşımlar, bulanık kural tabanlarına

dayandırılmaktadır.

Bulanık

kural

tabanlarına

alternatif

bir

yaklaşım

olarak

değerlendirilen Bulanık Regresyon Fonksiyonları’nın temeli ise Türkşen (2008)

tarafından yapılan çalışmada atılmıştır.

4

Bulanık Regresyon Fonksiyonları yaklaşımı üyelik değerlerini bugüne kadar uygulanan

diğer başka bulanık sistem modellerinden farklı bir biçimde ele almaktadır. Burada

üyelik değerleri, bir sistem davranışı hakkında bilgileri içinde barındıran ve her an

gücünü serbest bırakmak üzere etkinleştirilmiş atomlarmış gibi düşünülebilir. Üyelik

değerlerinden elde edilen bu potansiyel bilgiler, sistem modellerinin tahmin edicisi gibi

lokal bulanık fonksiyonlar içerisinde biriktirilirler. Bu nedenle, bir sistem için modeller

geliştirmek üzere, bulanık kural tabanlı yapıları kullanmak yerine Bulanık Regresyon

Fonksiyonlarının kullanımı önerilmektedir (Celikyilmaz ve Türksen 2009).

Benzerliklerin vektörler arasındaki uzaklıklara bağlı olarak açıklandığı bu sistem

modelleme yaklaşımlarında üyelik değerleri önemli rol oynamaktadır (Çelikyılmaz ve

Türkşen 2007). Türkşen ve Celikyilmaz (2006) tarafından yapılan çalışmada da üyelik

değerlerinin bulanık modeller üzerinde öneme sahip olduğu vurgulanmıştır. Bulanık

Regresyon Fonksiyonları yönteminin, klasik bulanık kural tabanlı sistem yaklaşımlara

göre sistem çıktısı ve model çıktısı arasındaki hatayı enküçükleyebilmesi açısından daha

iyi sonuçlar verdiği belirlenmiştir.

Yeni bir makine öğrenmesi tekniği olan Destek Vektör Makineleri (DVM) son

zamanlarda örüntü tanıma ve regresyon model kestirimi alanlarında oldukça ilgi

görmektedir. DVM ilk olarak 1995 yılında Vladimir N. Vapnik ve çalışma arkadaşları

tarafından ortaya atılmıştır (Vapnik 1995). İstatistiksel öğrenme teorisinde bu teknik,

deneysel risk minimizasyonundan

(Empirical Risk Minimization – DRM)

ziyade

yapısal risk minimizasyonuna (Structural Risk Minimization – YRM) dayandırılan bir

öğrenme algoritması olarak geliştirilmiştir. YRM tümevarım prensibi, sonlu

örneklemler için Vapnik–Chervonenkis (VC) boyutuna bağlı olarak optimum model

karmaşıklığını belirlemek üzere biçimsel bir mekanizma sağlar. Klasik sinir ağları ile

karşılaştırıldığında DVM, bir tek global optimum çözüm elde edebilir ve boyut sorunu

ile karşılaşmaz. Bu ilgi çekici özellikleri DVM’yi sıklıkla tercih edilir bir teknik haline

getirmektedir. DVM ilk olarak örüntü tanıma problemlerini çözmek üzere tasarlanmıştır

(Chiu ve Chen 2009, Min ve Cheng 2009, Chen vd. 2008, Shieh ve Yang 2008, Chen ve

Hsieh 2006, Yang vd. 2006, Jayadeva ve Chandra 2004, Tsujinishi ve Abe 2003).

Vapnik’in -duyarsız kayıp fonksiyonunun ortaya atılması ile birlikte DVM, fonksiyon

5

yakınsama ve regresyon model kestirimi problemlerine de genişletilmiştir (Wu 2009,

Dong vd. 2007).

Birçok gerçek hayat uygulamalarında ise gözlenen girdi verileri kesin olarak ölçülemez

ve sıklıkla sözel terimler ile açıklanır. Klasik destek vektör regresyon yönteminin nitel

verileri çözümleyememesinden dolayı bu konuda bulanık teori altyapısından

faydalanılması anlamlı hale gelmektedir. Bulanık mantığın, bulanık ve belirsiz verilerin

çözümlenmesinde güçlü bir araç olduğu gerçeğinden yola çıkarak bazı araştırmacılar,

bulanık destek vektör makinesi üzerinde çalışmalar yapmışlardır. İlk olarak Hong ve

Hwang (2003, 2005) çalışmalarında DVM’nin, çok değişkenli bulanık doğrusal ve

doğrusal olmayan regresyon modellerinde kullanımını önermişlerdir. Hong ve Hwang

(2003) tarafından önerilen destek vektör bulanık regresyon makinesi, bir karesel

programlama probleminin çözümü ile ortaya konulmuştur.

Jeng

vd.

(2003),

DVM’yi

aralık

regresyon

çözümlemesinde

kullanmıştır.

Çalışmalarında aralık regresyonu için iki radyal tabanlı fonksiyon ağı ile veri aralığının

alt ve üst sınırlarını açıklayan iki adımlı bir yaklaşım önermişlerdir. Radyal tabanlı

fonksiyon ağının başlangıç yapısı DVM öğrenme yaklaşımı ile elde edilmiştir. Sonuç

olarak ağın iyileştirilmesinde klasik geri yayılımlı öğrenme algoritması kullanılmıştır.

Hao ve Chiang (2008) çalışmalarında, kesin girdilere karşılık bulanık çıktı durumunda,

bulanık doğrusal (doğrusal olmayan) regresyon çözümlemesine ilişkin bir algoritma

önermiştir. Bu bulanık DVM yaklaşımında, mevcut eğitim verisi için bulanık çıktı

değerlerine, belirli bir uyum derecesine sahip bulanık regresyon modeli aranmaktadır.

Oluşturulan programlama problemi incelendiğinde, Tanaka vd. (1982) tarafından

önerilen bulanık regresyon yaklaşımının, DVM regresyon çözümlemesine uyarlandığı

görülmektedir.

Wu (2010) çok boyutlu zaman serisi kestiriminde bulanık DVM’nin yeni bir

uygulamasını geliştirmiştir. Birçok kestirim probleminde sınırlı sayıda örnek ve bulanık

veri mevcut olması dolayısıyla; kapsamlı bulanık değerlendirmeler sonucunda girdi –

çıktı değişkenlerinin bulanık sayılar ile açıklanması önem arz etmektedir. Bu çalışmada,

6

girdi değişkenlerinin bulanıklık derecesini temsil etmek üzere simetrik üçgensel bulanık

sayılardan faydalanılmıştır. Bulanık teori ile -destek vektör makinesi birleştirilerek

simetrik üçgensel bulanık sayılar için bulanık -destek vektör makinesi yaklaşımı

sunulmuştur.

7

2. İSTATİSTİKSEL ÖĞRENME TEORİSİ

1960’lı yılların sonlarında geliştirilen istatistiksel öğrenme teorisi, 1990’lara kadar veri

setinden fonksiyon tahmin probleminin bir teorik çözümlemesi olarak kalmıştır. 1990’lı

yılların ortalarında ise bu teoriye dayandırılan ve destek vektör makineleri (Support

Vector Machine – DVM) olarak adlandırılan yeni bir öğrenme algoritması önerilmiştir.

Böylece istatistiksel öğrenme teorisi, sadece teorik çözümlemeler için değil aynı

zamanda çok boyutlu fonksiyon tahmininde de kullanışlı algoritmalar geliştirmek üzere

etkili bir araç haline gelmiştir. Bu bölümde, kuramsal ve algoritmik yönleri ile

istatistiksel öğrenme teorisi incelenecektir.

2.1 Öğrenme Probleminin Yapısı

Öğrenme, kısıtlı sayıda gözlemler kullanarak girdi ve çıktı arasındaki bilinmeyen

bağımlılığın veya sistem yapısının tahmin edilmesi sürecidir. Veriden öğrenme modeli,

•

•

•

Olasılık (yoğunluk) fonksiyonu olan rasgele vektörlerinin üreticisi,

⁄ koşullu olasılık (yoğunluk) fonksiyonuna göre her bir girdi vektörü

için bir çıktısını belirleyen sistem,

, Ω kümesinden bir parametre olmak üzere; , , kümesini uygulayabilecek bir öğrenme makinesi

Ω fonksiyon

biçiminde verilen üç bileşen (Şekil 2.1) yardımıyla açıklanabilir (Vapnik 1998).

Öğrenme problemi, verilen , , Ω fonksiyonlar kümesinden sistem yanıtını

mümkün en iyi yol ile tahmin eden fonksiyonu seçmektir. Seçim, , !

⁄ ortak olasılık (yoğunluk) fonksiyonuna göre rasgele seçilmiş birbirinden

bağımsız aynı dağılımlı gözlemin oluşturduğu # , # , … , % , % eğitim kümesine

dayalıdır.

8

Üretici

Öğrenme

Makinesi

Sistem

,

Şekil 2.1 Öğrenme makinesi modeli

2.1.1 Öğrenmenin amacı

İstatistiksel model tahmini çerçevesinde öğrenmenin amacı, bilinmeyen bir sistemin

doğru tanımlanması iken; kestirimsel öğrenmede amaç, sistem çıktısının doğru taklit

edilmesidir. Buna göre, amaçları itibariyle bakıldığında sistem tanımlamasının, sistem

taklidinden daha tercih edilir olduğu açıktır. Örneğin, doğru bir sistem tanımlaması girdi

örneklemlerinin dağılımına bağlı değilken; iyi bir kestirimsel model genellikle bu

(bilinmeyen) dağılıma koşulludur. Bundan dolayı, sistem tanımlama yaklaşımına göre

doğru bir model, kestirimsel açıdan iyi genellemeye sahip olacaktır ancak bunun tersi

doğru değildir. Sistem tanımlamanın matematiksel işlemlerinin sonucu olarak bir

fonksiyon yakınsama yapısına ulaşılır ve bu konuda esas problem de boyut sorunudur.

Bunun aksine, kestirimsel öğrenmede belirlenen amaç ile Vapnik–Chervonenkis (VC)

öğrenme teorisine ulaşılır (Vapnik 1998).

Sistem yanıtının mümkün en iyi tahmine ulaşmak üzere; verilen bir girdisi için sistem

yanıtı ile öğrenme makinesi tarafından elde edilen , arasındaki kayıp veya

uyuşmazlık ölçülür. Risk fonksiyonu olarak tanımlanan &, '(, , ) kayıp

fonksiyonunun beklenen değeridir ve

& ! * '(, , ) , ++

(2.1)

biçiminde tanımlanır (Vapnik 1999). Burada amaç, , ortak olasılık (yoğunluk)

fonksiyonunun bilinmediği ve tek mümkün bilginin eğitim veri setinde barındırıldığı bir

9

durumda, & risk fonksiyonunu ( , , Ω fonksiyonlar kümesi üzerinde)

minimum yapacak , - fonksiyonunu bulmaktır.

2.1.2 Temel öğrenme problemleri

Öğrenme probleminin oldukça genel olan formülasyonu esasında birçok özel problemi

kapsamaktadır. Bu kesimde, örüntü tanıma problemleri, regresyon fonksiyonu tahmini

ve olasılık (yoğunluk) fonksiyonu tahmini biçiminde belirlenen üç temel problem

incelenecektir.

Tanım 2.1 Örüntü tanıma problemi

Sistem çıktısı olan ’nin sadece iki değer alması ! .0, 11 ve , , Ω gösterge

fonksiyonlar (sadece 0 ve 1 değerlerini alan fonksiyonlar) kümesini göstermesi

durumunda,

0, ! , 4

'(, , ) ! 2

1, 3 , (2.2)

biçiminde verilen bir kayıp fonksiyonu göz önüne alınsın. Bu tür bir kayıp fonksiyonu

kullanıldığında, (2.1) denklemi hatalı sınıflandırma olasılığını verir. Bundan dolayı;

problem, , olasılık ölçüsünün bilinmediği ancak # , # , … , % , % eğitim

kümesinin mevcut olduğu durumda, hatalı sınıflandırma olasılığını minimum yapan

fonksiyonu belirlemektir (Vapnik 1999).

Tanım 2.2 Regresyon fonksiyonu tahmin problemi

Reel değerler alan sistem yanıtı için , , , - ! * ⁄+

Ω fonksiyonlar kümesi,

(2.3)

10

biçimindeki regresyon fonksiyonunu içersin. Eğer 5, fonksiyonu,

'(, , ) ! ( 7 , )

6

'6 ise regresyon

(2.4)

kayıp fonksiyonunu ile & riskini minimum yapan fonksiyondur. Böylece regresyon

tahmin problemi, , olasılık ölçüsünün bilinmediği ancak # , # , … , % , % eğitim kümesinin mevcut olduğu durumda, eşitlik (2.4)’deki kayıp fonksiyonu

kullanıldığında; (2.1) eşitliği ile verilen risk fonksiyonunun minimum yapılması

problemidir (Vapnik 1999).

Tanım 2.3 Olasılık (yoğunluk) fonksiyonu tahmin problemi

, , Ω olasılık (yoğunluk) fonksiyonları kümesinden olasılık (yoğunluk)

fonksiyonu tahmin problemi için

'(, ) ! 7 log , (2.5)

biçiminde verilen bir kayıp fonksiyonu göz önüne alınsın. Aranılan fonksiyonun, (2.5)

eşitliğindeki kayıp fonksiyonu kullanıldığında, (2.1) denklemi ile verilen risk

fonksiyonunu minimum yapması istenmektedir. Buna göre, olasılık ölçüsünün

bilinmediği fakat birbirinden bağımsız aynı dağılımlı # , 6 , … , % veri setinin mevcut

olması durumunda, veriden olasılık (yoğunluk) fonksiyonu tahmini için yine bir risk

fonksiyonunun minimum yapılması gerekmektedir (Vapnik 1999).

2.1.3 Deneysel risk minimizasyonu

: ! , girdi-çıktı ikililerini göstermek üzere ;:, , Ω kayıp fonksiyonlar

kümesi göz önüne alınsın. Bir öğrenme probleminde bilinmeyen bir : olasılık

(yoğunluk) fonksiyonuna göre üretilmiş sayıda birbirinden bağımsız ve aynı dağılımlı

11

eğitim veri seti <% ! .:# , :6 , … , :% 1 mevcut olduğunda kestirimsel öğrenme

yaklaşımında amaç,

& ! * ; :, :+: ,

Ω

(2.6)

risk fonksiyonunu minimum yapan ;:, - fonksiyonunu bulmaktır.

: olasılık (yoğunluk) fonksiyonunun bilinmediği durumda, (2.6) eşitliği ile verilen

risk fonksiyonunu minimum yapmak amacıyla; beklenen risk fonksiyonu & ,

<% ! .:# , :6 , … , :% 1 deneysel veri seti temeli üzerine kurulan deneysel risk fonksiyonu,

#

&=>? ! % ∑%B# ;:A , (2.7)

ile yer değiştirilir.

Eşitlik (2.6)’daki risk fonksiyonunu minimum yapan ;:, - fonksiyonuna, (2.7)

eşitliği ile verilen deneysel riski minimum yapan ;:, % fonksiyonu ile

yakınsanmasına deneysel risk minimizasyonu (Empirical Risk Minimization – DRM)

tümevarım prensibi adı verilmektedir (Kecman 2001, Cherkassky ve Mulier 2007).

Regresyon tahmin problemlerinde kullanılan en küçük kareler veya yoğunluk tahmin

problemlerinde kullanılan maksimum olabilirlik gibi klasik yöntemler, belirli kayıp

fonksiyonları ile DRM prensibinin özel bir halidir. Aslında, bir regresyon problemi,

# , # , … , % , % eğitim veri seti için (2.4) eşitliğinde gösterilen kayıp fonksiyonu ile

tanımlanır. (2.7) eşitliği ile verilen risk fonksiyonu kullanılarak regresyon model

tahmini (en küçük kareler yöntemi) için minimum yapılması gereken,

#

&=>? ! % ∑%B#( 7 , )

6

fonksiyonuna ulaşılır.

12

(2.8)

, , Ω olasılık (yoğunluk) fonksiyonları kümesinden olasılık (yoğunluk)

fonksiyonu tahmin probleminde, eşitlik (2.5) ile verilen kayıp fonksiyonu kullanılabilir.

Bu kayıp fonksiyonu, (2.7) eşitliği ile verilen risk fonksiyonunda yerine konulduğunda,

#

&=>? ! 7 % ∑%B# log , (2.9)

fonksiyonu elde edilir. &=>? ’nın minimumu, olasılık (yoğunluk) fonksiyonunun

aynı zamanda maksimum olabilirlik tahminidir.

Öğrenme teorisi,

i)

DRM prensibinin tutarlılığı için koşullar nelerdir? (Öğrenme sürecinin tutarlılığı

teorisi)

ii) Deneysel risk değerlerinin en küçüklerinin dizisinin, gerçek en küçük riske olan

yakınsama hızı nedir? Bir başka ifadeyle; deneysel risk minimizasyon prensibini

uygulayan bir öğrenme makinesinin genelleme derecesi nedir? (Öğrenme sürecinin

yakınsama derecesinin asimptotik olmayan teorisi)

iii) Öğrenme makinesinin yakınsama derecesi (genelleme derecesi) nasıl kontrol

edilebilir? (Öğrenme sürecinin genelleme kabiliyetini kontrol etme teorisi)

iv) Genelleme derecesini kontrol edebilen bir algoritma nasıl oluşturulabilir? (Öğrenme

algoritmalarının oluşturulması teorisi)

biçiminde verilen dört soruya çözüm arar (Vapnik 1999).

Birinci sorunun yanıtına, rasgele değişkenlerin bir dizisinin olasılıkta yakınsaması için

gerek ve yeter şartların belirlenmesi ile ulaşılabilir:

a) & % risk değerlerinin riskin mümkün minimum değeri olan & - ’a

yakınsaması yani, C ∞ için

13

E

&% FGGH &- (2.10)

dır. Burada & % , ! 1,2, … değerleri, her biri &=>? % deneysel riskini

minimum yapan ; :, % kayıp fonksiyonları için beklenen risklerdir. (2.10)

denklemi, DRM prensibi kullanılarak bulunan çözümlerin, mümkün en iyi risk

değerine olasılıkta yakınsadığını göstermektedir.

b) &=>? % , ! 1,2, … deneysel risk değerlerinin riskin mümkün minimum

değeri olan & - ’a yakınsaması yani, C ∞ için

E

&=>? % FGGH & - (2.11)

dır. (2.11) denklemi, deneysel risk değerlerinin, mümkün en küçük risk değerine

olasılıkta yakınsadığını göstermektedir.

Burada, &% değerlerinin olasılıkta yakınsaması, J K 0 ve JL K 0 için öyle bir

- ! - , L sayısı vardır öyle ki J K - için en az 1 7 L olasılık ile

& % 7 &ω- N eşitsizliği sağlanır, anlamına gelmektedir.

Şekil 2.2 ile de gösterildiği gibi ; :, % kayıp fonksiyonlarının bir dizisi için beklenen

risk ve deneysel risk, aynı (mümkün en küçük) risk değerine yakınsıyor ise DRM

yöntemi tutarlıdır, denir Ayrıca, verilen bir eğitim veri seti için öğrenme makinesi

genellikle deneysel riski minimum yapan fonksiyonu seçeceğinden, &=>? % N

& % olması beklenilir. Başka bir ifade ile sayıda örneklem için DRM prensibine

göre belirlenen ; :, % fonksiyonları, gerçek riski minimum yapan en iyi

fonksiyonların yanlı tahminleri olduğu söylenilir. C ∞ için (büyük sayılar yasası

gereği) deneysel riskin, beklenen riske (belirli bir değeri için) yakınsaması arzu edilir.

14

Ancak burada tutarlılık özelliği, deneysel riski minimum yapan parametre kümesinin,

gerçek riski de kendi kendine minimum yapacağı anlamına gelmemektedir. Bu nedenle

DRM yönteminin tutarlılığının, fonksiyonlar kümesinin belirli bir elemanının

özelliklerine bağlı olmadığının ortaya konulması amacıyla; (2.10) ve (2.11) denklemi ile

verilen tutarlılık koşullarının, tüm (kabul edilebilir) fonksiyonlar için sağlanması

gerekmektedir. Bu koşul, güçlü tutarlılık olarak bilinir (Vapnik 1995, 1998). Güçlü

tutarlılık kavramı, belirlenen en iyi fonksiyonun küme içerisinden çıkarılmasından sonra

da DRM prensibinin tutarlı kalmasını gerektirir. Bir sonraki kesimde verilecek olan

öğrenme teorisinin anahtar teoremi, DRM tümevarım prensibinin güçlü tutarlılığı için

gerek ve yeter şartları temin eder.

Beklenen risk & % minQ &

Deneysel risk &=>? % Şekil 2.2 DRM prensibinin tutarlılığı

2.2 Öğrenme Sürecinin Tutarlılığı Teorisi

Gözlem sayısı arttığında, deneysel risk minimizasyonu yöntemi kullanılarak elde edilen

çözümlerin mümkün en iyiye yakınsaması için gerek ve yeter şartları açıklayan tutarlılık

teorisi bir asimptotik teoridir. Burada amaç, örneklem hacmi küçük (sonlu) olduğunda

bir algoritma oluşturmak ise tutarlılık teorisine neden ihtiyaç duyulduğu sorusu

gündeme gelmektedir. Deneysel risk minimizasyonu tümevarım yönteminde yakınsama

15

durumu için tutarlılık teorisi, sadece yeter değil gerek şartları da açıklamaktadır.

Bundan dolayı tutarlılık teorisine ihtiyaç duyulmaktadır.

Bu kesimde, DRM prensibinin genelleme kabiliyetini tanımlayan Vapnik–Chervonenkis

(VC) entropi kavramı ele alınacak ve daha sonra öğrenmenin asimptotik olmayan

teorisinin, belirli sayıda gözlem için bu kavramı değerlendiren farklı tip sınırlara dayalı

olduğu gösterilecektir.

2.2.1 Öğrenme teorisinin anahtar teoremi

Sınırlı kayıp fonksiyonlarına sahip ;:, , alınsın. Buna göre, eğer

R S * ;:, :+: S T , J

Ω fonksiyonlar kümesi göz önüne

Ω

(2.12)

ise DRM prensibinin tutarlı olması için gerek ve yeter şart; &=>? deneysel riskinin,

& gerçek risk değerine ; :, , lim%CU V WsupQ

Ω [& Ω fonksiyonlar kümesi üzerinde,

7 &=>? \ K ] ! 0 , J K 0

(2.13)

biçiminde düzgün yakınsak olmasıdır (Vapnik ve Chervonenkis 1991). Bu tip bir

yakınsamaya da düzgün tek taraflı yakınsama denir.

Başka bir ifadeyle anahtar teoreme göre; DRM prensibinin tutarlılığının koşulları,

(2.13) denklemi ile verilen düzgün tek taraflı yakınsaklığın mevcut olması koşullarına

denktir. Bu teorem, DRM prensibinin yakınsaklık özelliğinin herhangi bir analizinin, en

kötü durum çözümlemesi olması gerektiği anlamına gelmesi dolayısıyla anahtar teorem

olarak adlandırılmaktadır. Buna göre, tutarlılık için gerek şart (sadece yeter şart değil),

belirli bir fonksiyonlar kümesi üzerinde en kötü fonksiyon için

16

∆=% _öaü ! supQ

Ω [& 7 &=>? \

(2.14)

biçiminde verilen sapmanın olasılıkta sıfıra yakınsamasıdır (Vapnik 1999).

2.2.2 Düzgün yakınsaklık için gerek ve yeter şartlar

(2.13) denklemi ile verilen düzgün yakınsaklık için gerek ve yeter şartları açıklamak

üzere; sayıda örnek üzerinde ;:, , Ω fonksiyonlar kümesi için entropi olarak

adlandırılan kavram tanıtılacaktır. Buna göre, ilk olarak gösterge fonksiyonlar kümesi

ve daha sonra ise gerçel değerli fonksiyonlar kümesi için entropi kavramı ele

alınacaktır.

Tanım 2.4 Gösterge fonksiyonlar kümesi için entropi

; :, , Ω gösterge fonksiyonlar kümesi olsun ve <% ! .: , c ! 1, 2, … , 1

örneklemi göz önüne alınsın. Belirli bir örneklem üzerinde, ;:, , Ω fonksiyonlar

kümesinin çeşitliliği ise d <% değeri ile tanımlansın. Gösterge fonksiyonlar

kümesinden fonksiyonlar kullanılarak elde edilebilen d <% değeri, örneklemin farklı

parçalanmalarının sayısını göstermektedir. Başka bir biçimle; , Ω parametre

kümesinden farklı değerler aldığı zaman - boyutlu ikili vektörlerin kümesi,

e ! (;:# , , … , ;:% , ) , Ω

(2.15)

ile ifade edildiğinde, geometrik olarak d <% değeri, <% ! .: , c ! 1, 2, … , 1

örneklemi ve ;:, , Ω fonksiyonlar kümesine bağlı olarak elde edilebilen -

boyutlu küpün farklı köşe noktalarının sayısını göstermektedir. Ayrıca,

f<% ! ln d<% (2.16)

17

değerine de rasgele entropi adı verilir (Vapnik 1999). Rasgele entropi, belirli bir

örneklem üzerinde fonksiyonlar kümesinin çeşitliliğini açıklamaktadır. Burada f<% bir rasgele değişkendir. g :# , … , :% ortak dağılım fonksiyonu üzerinde rasgele

entropinin beklenen değeri,

f ! hiln d<% j

(2.17)

göz önüne alınsın. Bu değer, sayıda örneklem üzerinde ;:, , Ω gösterge

fonksiyonlar kümesinin entropi miktarı olarak adlandırılır. Burada beklenen değer,

; :, , Ω fonksiyonlar kümesine, (bilinmeyen) g : dağılım fonksiyonuna ve gözlem sayısına bağlıdır. Entropi, verilen gösterge fonksiyonlar kümesinin, sayıda

örneklem için beklenen çeşitliliğini belirtmektedir.

Örüntü tanıma problemleri (gösterge kayıp fonksiyonu) için tutarlılık teorisinin başlıca

sonucu teorem 2.1 ile verilir.

Teorem 2.1: &=>? deneysel riskinin, & gerçek risk değerine çift taraflı düzgün

yakınsaması yani,

lim%CU VksupQ Ωl& 7 &=>? l K m ! 0 , J K 0

(2.18)

için gerek ve yeter şart,

lim%CU

n%

%

! 0 , J K 0

(2.19)

eşitliğinin sağlanmasıdır (Vapnik ve Chervonenkis 1971, Mendelson 2003).

(2.19) eşitliği ile verilen koşulun yeniden düzenlenmesiyle, eşitlik (2.13)’deki tek taraflı

düzgün yakınsaklık için de gerek ve yeter şartlar elde edilebilir.

18

Tanım 2.5 Gerçel fonksiyonlar kümesi için entropi

Entropi kavramını gerçel değerli fonksiyonlar için genellemek üzere; R S ;:, S

T, Ω sınırlandırılmış fonksiyonlar kümesi göz önüne alınsın. Bu fonksiyonlar

kümesini ve <% ! .: , c ! 1, 2, … , 1 eğitim veri setini kullanarak -boyutlu gerçel

değerli vektörlerin bir kümesi,

e ! (;:# , , … , ;:% , ) , Ω

(2.20)

biçiminde oluşturulabilir. Vektörlerin bu kümesi, o metriğinde sonlu bir 7 pq’e

sahiptir.

Burada 7 pq şöyle tanımlanır: Eğer herhangi bir e r , r

Ω vektörü için belirli

bulanabiliyorsa ve d ! d; <% sayısı mevcut ise e , Ω vektörler kümesi

bir metrik üzerinde bu vektöre, uzaklıkta olan bir es e# , … , e t vektörü

minimal 7 pq’e sahiptir denir. Burada d, o metriğinde,

v(er , es ) ! maks#yy% |;: , r 7 ;: , s | S (2.21)

özelliğini sahip vektörlerin minimum sayısıdır (Vapnik 1999).

Buna göre, d; <% rasgele değişkeninin logaritması olan

f; <% ! ln d; <% değişkenine,

<% ! .: , c ! 1, 2, … , 1

(2.22)

örneklemi

için

R S ;:, S T, Ω

fonksiyonlar kümesinin rasgele VC-entropisi adı verilir. Burada tanımlanan VC-entropi,

; :, , Ω fonksiyonlar kümesinin minimum 7 pq’inin kardinalitesi d ile

gösterilmek üzere,

19

f_{|}_ ! ln d (2.23)

biçimindeki klasik metriksel -entropiden farklıdır.

Rasgele VC-entropinin beklenen değeri,

f; ! hif ; <% j

(2.24)

sayıda örneklem için R S ;:, S T, olarak adlandırılır.

Ω fonksiyonlar kümesinin entropi miktarı

Sınırlandırılmış kayıp fonksiyonu için gerçek riske deneysel riskin düzgün yakınsaklığı

teorisinin başlıca sonuçları arasında Teorem 2.2’de yer alır.

Teorem 2.2: Deneysel riskin gerçek riske çift taraflı düzgün yakınsaması yani,

lim%CU VksupQ Ωl& 7 &=>? l K m ! 0 , J K 0

(2.25)

için gerek ve yeter şart,

lim%CU

n~,%

%

! 0 , J K 0

(2.26)

eşitliğinin sağlanmasıdır (Vapnik 1995, 1998).

(2.26) eşitliği ile verilen koşulun yeniden düzenlenmesiyle eşitlik (2.13)’deki tek taraflı

düzgün yakınsaklık için de gerek ve yeter şartlar elde edilebilir.

20

2.2.3 Öğrenme teorisinin üç aşaması

Bu kesimde, basite indirgemek açısından bir ;:, , Ω gösterge fonksiyonlar

kümesi (örüntü tanıma problemi) ele alınsın. Gösterge fonksiyonlar kümesi ile elde

edilen sonuçlar, gerçel değerli fonksiyonlar için genellenebilir.

Kesim 2.2.2’de gösterge fonksiyonlar kümesi için

f ! hiln d<% j

biçiminde tanımlanan entropi kavramı ele alınmıştı. Burada, d<% değerlerine

dayandırılarak oluşturulan iki yeni fonksiyon olarak,

f|%% ! ln hid<% j

(2.27)

tavlanmış (annealed) VC-entropisi ve

! ln sup< d<% (2.28)

büyüme fonksiyonu göz önüne alınsın. Bu fonksiyonlar, herhangi bir için

f S f|%% S S ln 2

(2.29)

eşitsizliği sağlanacak biçimde belirlenir (Cherkassky ve Mulier 2007). Bu fonksiyonlara

dayandırılarak da istatistiksel öğrenme teorisinde başlıca üç aşama oluşturulur (Vapnik

1999).

Teorem 2.1’de DRM prensibinin tutarlılığı için gerek ve yeter şartı açıklayan,

lim%CU

n%

%

! 0 , J K 0

21

denklemi tanıtılmıştı. Bu denklem öğrenme teorisinin birinci aşaması olarak

değerlendirilir ve deneysel riski minimum yapan herhangi bir makine bu şartı

sağlamalıdır.

Fakat (2.19) denklemi, elde edilen &% risklerinin, mininum olan &- ’a yakınsama

hızı konusunda herhangi bir bilgi vermemektedir. Ayrıca, DRM prensibinin tutarlı olup

da gelişigüzel yavaş bir asimptotik yakınsama derecesine sahip olması durumu da söz

konusudur. Bundan dolayı, hangi koşullar altında asimptotik yakınsama derecesinin

hızlı olacağı belirlenmelidir. Buna göre, K 0 bir sabit ve K - olmak üzere,

V.& % 7 & - K 1 N p %~

üstel sınır sağlanırsa asimptotik yakınsama derecesinin hızlı olduğu söylenir (Bousquet

vd. 2003). Sonuç olarak,

lim%CU

n

%

%

!0

(2.30)

denklemi hızlı yakınsama için yeter şartı ifade etmektedir. Bu denklem öğrenme

teorisinin ikinci aşaması olarak değerlendirilir ve hızlı bir asimptotik yakınsama

derecesi temin eder (Vapnik 1999).

DRM yönteminin hem tutarlılık için gerek ve yeter şartını açıklayan ve hem de hızlı

yakınsaklık için yeter şartını açıklayan denklemleri, belirli bir g : dağılım fonksiyonu

için geçerlidir yani, VC-entropisi, f ve tavlanmış VC-entropisi f|%% , dağılım

fonksiyonu kullanılarak belirlenir. Ancak istatistiksel öğrenme teorisinde amaç, farklı

birçok problem için bir öğrenme makinesi geliştirmektir. Buna göre; DRM prensibinin

hangi şartlar altında dağılımdan bağımsız, tutarlı ve hızlı yakınsak olduğu

incelenmelidir. Herhangi bir dağılım fonksiyonu için DRM prensibinin tutarlılığını

belirleyen gerek ve yeter şart,

22

lim%CU

%

%

!0

(2.31)

denklemi ile açıklanır. Ayrıca bu denklem, hızlı yakınsaklık için de yeter şarttır (Vapnik

1999).

(2.31) eşitliği, öğrenme teorisinin üçüncü aşaması olarak değerlendirilir ve ele alınan

problemden bağımsız olarak, öğrenme makinesini uygulayan DRM prensibinin hangi

koşul altında yüksek dereceden asimptotik yakınsaklığa sahip olduğunu açıklar.

Bu kesimde verilen üç aşama, öğrenme makinesinin yakınsaklık derecesi için hem

dağılımdan bağımsız sınırlar hem de dağılıma bağımlı sınırlar geliştirmek üzere bir

temel oluşturur.

2.3 Büyüme Fonksiyonu ve Vapnik–Chervonenkis Boyutu

Belirli bir örneklem sayısı için DRM yönteminin kalitesini belirlemek amacıyla düzgün

yakınsaklık derecesi üzerinde asimptotik olmayan sınırların belirlenmesi gerekmektedir.

Yakınsaklık derecesinin asimptotik olmayan sınırı; büyüme fonksiyonu için yapısal bir

sınır elde etmeye de imkan sağlayan, Vapnik–Chervonenkis (VC) boyutu olarak

adlandırılan yeni bir kapasite kavramı kullanılarak belirlenebilir. VC-boyutu kavramı,

büyüme fonksiyonunun önemli bir özelliğine dayanmaktadır.

2.3.1 Büyüme fonksiyonunun yapısı

Öğrenme makinesinin genelleme kapasitesi üzerinde dağılımdan bağımsız sınırlar

geliştirmek üzere, eşitlik (2.31) ile verilen büyüme fonksiyonunun değerlendirilmesi

gerekmektedir. Bu da yakınsama fonksiyonlarının VC boyutu kavramının kullanılması

ile gerçekleştirilebilir.

Teorem 2.3: bir tamsayı olmak üzere i ! ln 2j ve i 1 3 1 ln 2j

için herhangi bir büyüme fonksiyonu ya

23

%

S [ln 1\

(2.32)

eşitsizliği tarafından sınırlandırılır ya da

! ln 2

(2.33)

eşitliğini sağlar. Diğer bir ifade ile büyüme fonksiyonu, Şekil 2.3’de gösterildiği gibi ya

doğrusal bir fonksiyon ya da bir logaritmik fonksiyon tarafından sınırlandırılmış

olacaktır (Vapnik ve Chervonenkis 1971). Örneğin; büyümü fonksiyonu, ! √

formunda olamayacaktır.

ln 2

ln⁄ 1

Şekil 2.3 Büyüme fonksiyonunun davranışı

Eğer ;:, , Ω gösterge fonksiyonlar kümesi için büyüme fonksiyonu doğrusal ise

bu fonksiyonlar kümesinin VC boyutunun sonsuz olduğu söylenir. Ayrıca, eğer

; :, , Ω gösterge fonksiyonlar kümesi için büyüme fonksiyonu, katsayısı ile

bir logaritmik fonksiyon tarafından sınırlandırılmış ise bu fonksiyonlar kümesinin VC

boyutunun sonlu ve değerine eşit olduğu söylenir.

24

Öğrenme makinesi tarafından uygulanan gösterge fonksiyonlar kümesinin VC

boyutunun sonluluğu, DRM yönteminin tutarlılığı için dağılımdan bağımsız olarak

gerek ve yeter şartı belirler. VC boyutunun sonlu olması aynı zamanda hızlı

yakınsamayı da gerektirmektedir (Kecman 2001).

2.3.2 Vapnik–Chervonenkis boyutu

Bu kesimde, gösterge fonksiyonlar kümelerinin VC boyutunun eşdeğer bir

tanımlamasının verilmesinin ardından bu tanımlama, gerçel değerli fonksiyonlar

kümeleri için genellenecektir.

Tanım 2.6 Gösterge fonksiyonlar kümesinin VC boyutu

; :, , Ω

gösterge

fonksiyonlar

kümesinin

VC

boyutu,

bu

kümenin

fonksiyonlarını kullanarak (bu fonksiyonlar kümesi tarafından) 2 mümkün yol ile

parçalanabilen :# , … , : vektörlerinin maksimum sayısı olan değeridir. Eğer, her için ;:, , Ω kümesi tarafından parçalanabilen sayıda vektörün bir kümesi

mevcut ise VC boyutu sonsuza eşittir (Vapnik 1999).

(2.31) ve (2.32) ile verilen denklemlere göre VC boyutunun sonlu olması, DRM

yönteminin tutarlılığı ve hızlı yakınsaklığı için gerek ve yeter şartları belirler. Bundan

dolayı; VC boyutu kavramı, öğrenme teorisinde dağılımdan bağımsız sonuçlar elde

etmede önemlidir. Ayrıca, dağılımdan bağımsız tüm bu yardımcı sonuçlar da kayıp

fonksiyonları kümesinin VC boyutuyla ilişkilidir.

Şekil 2.3’deki büyüme fonksiyonunun doğrusal parçasına göre; örneklem sayısı, (sonlu)

VC boyutunu aşıyorsa sonlu bir örneklem ile öğrenmenin mümkün olabileceği sezgisel

olarak belirlenir. Başka bir ifade ile yakınsama fonksiyonlarının kümesi çok esnek

olmamalıdır ve bu da fonksiyonlar kümesinin kapasitesi ile açıklanır. Ayrıca bu

sonuçlar, dağılımdan bağımsız olarak öğrenmenin mümkün olduğunu göstermektedir.

25

(2.29) ve (2.32) ile verilen eşitsizlikler birleştirildiğinde, VC teorisinde ele alınan

kapasite kavramına ilişkin

%

f S f|%% S S [ln 1\

(2.34)

sonucuna ulaşılır. (2.34) eşitsizliğine göre entropi tabanlı kapasite yaklaşımı, en doğru

yol olmasına rağmen dağılıma bağımlı olması dolayısıyla en zor belirlenendir. Bunun

aksine, VC boyutu, doğruluğu en az ancak en kullanışlı kavramdır. Birçok uygulama

probleminde, veri sayısı az ve boyutunun yüksek olmasından dolayı; kapasite

(karmaşıklık) kontrolü için olasılık (yoğunluk) fonksiyonu tahmini söz konusu değilken;

en kullanışlı seçim VC boyutunun kullanılmasıdır (Vapnik 1995).

Tanım 2.7 Gerçel değerli fonksiyonlar kümesinin VC boyutu

S ;:, S R, Ω; ve R (, 7∞ ve R, ∞’a değerini alabilir) sabitleri tarafından

sınırlandırılmış gerçel değerli fonksiyonların bir kümesi olsun.

N N R olacak biçimde katsayılar ve ,

! W

0, N 04

1, 0

(2.35)

bir adım fonksiyonu olmak üzere;

:, , ! .; :, 7 1 , Ω

gösterge fonksiyonlar kümesi ile ; :, , önüne alınsın.

26

(2.36)

Ω gerçel değerli fonksiyonlar kümesi göz

Şekil 2.4’de görüldüğü üzere; ;:, , Ω gerçel değerli fonksiyonlar kümesinin VC

boyutu, (2.36)’da verilen gösterge fonksiyonlar kümesinin VC boyutu ile tanımlanır

(Vapnik 1995, 1998).

;:, 1

i; :, K j

0

<

Şekil 2.4 Gerçel değerli fonksiyonlar kümesinin VC boyutu

2.4 Genelleme Üzerine Sınırlar

Bu kesimde, DRM yöntemine dayalı bir öğrenme sürecinin düzgün yakınsaklık derecesi

üzerine üst sınırlar verilecektir. Örneklem sayısı ’nin bir fonksiyonu olan bu sınırlar,

bilinmeyen

dağılım

fonksiyonu

g :’nin,

kayıp

fonksiyonunun,

yakınsama

fonksiyonlarının özelliklerine bağlıdır ve (bilinmeyen) gerçek risk ile bilinen bir

deneysel risk arasındaki farkı değerlendirir. Buna göre, belirli bir örneklem sayısı için

deneysel riski minimum yapan ; :, % kayıp fonksiyonu göz önüne alınsın. & % , bu

kayıp fonksiyonuna göre gerçek riski ve &=>? % ise deneysel riski göstermek üzere;

genelleme sınırları,

•

& % gerçek riski, minimum deneysel risk değeri &=>? % ’e ne kadar

yakındır?

27

•

& % gerçek riski, mümkün minimum risk değeri & - ! minQ & ’a ne

kadar yakındır?

biçiminde verilen iki soruya çözüm arar.

Kesim 2.3’te; VC entropisi, büyüme fonksiyonu ve VC boyutu gibi birbirinden farklı

bazı kapasite kavramları tanıtılmıştı. (2.34) ile verilen eşitsizliğe göre en doğru

genelleme sınırları, VC entropisine dayalı olarak elde edilebilir. Fakat, VC entropisi,

(bilinmeyen) dağılımın özelliklerine bağlı olmasından dolayı kolaylıkla belirlenemez ve

kullanışlı değildir (Vapnik 1995). Bu kesimde, büyüme fonksiyonu ve VC boyutu gibi

dağılım varsayımı gerektirmeyen kapasite kavramları ele alınacaktır. Bu sınırlar da

yapısal risk minimizasyonu (Structural Risk Minimization – YRM) olarak adlandırılan

yeni bir tümevarım prensibinin gelişmesini sağlamıştır. Buna göre, (sınıflandırma

problemleri için) sınırlandırılmış negatif olmayan kayıp fonksiyonları ve (regresyon

problemleri için) sınırlandırılmamış negatif olmayan kayıp fonksiyonları incelenecektir.

2.4.1 Sınıflandırma

Öğrenme makinesi tarafından negatif olmayan kayıp fonksiyonlarının (0/1 kayıp

fonksiyonu) kullanıldığı ikili sınıflandırma problemleri göz önüne alınsın. Bu durumda,

tamamen sınırlandırılmış olan fonksiyon kümeleri için sınırlara ilişkin teorinin başlıca

sonucu olarak Teorem 2.4 verilir (Vapnik 1982, 1995, 1999).

Teorem 2.4: En az 1 7 L olasılık ile (DRM’yi uygulayan) öğrenme makinesinin

genelleme kabiliyeti için

& S &=>? 1 1

~

6

[ Q\

~

(2.37)

eşitsizliği, deneysel riski minimum yapan ;:, % fonksiyonunu da içeren tüm ;:, fonksiyonları için eşanlı olarak sağlanır (Vapnik 1999). ;:, kayıp fonksiyonlar

28

kümesi sonsuz sayıda eleman içerdiği zaman yani her bir elemanın (fonksiyonun)

sürekli parametre değerleri ile belirlendiği bir parametre ailesi için

%

! [ ,

%

\ ! #

[ #\⁄

%

(2.38)

dır. Kayıp fonksiyonlar kümesi sonlu d sayıda eleman içeriyor ise

!2

t

(2.39)

%

olarak alınır.

İstatistiksel öğrenme teorisine göre Vapnik (1982, 1995, 1998), # ve 6 sabitlerinin

sırasıyla 0 N # S 4 ve 0 N 6 S 2 aralığında olması gerektiğini göstermiştir. # ! 4

ve 6 ! 2 değerleri, en kötü durum dağılımlarına (kesikli dağılım fonksiyonu) uygun

olarak belirlenir ve bu durumda,

!4

[

#\⁄

(2.40)

%

dır. Ancak uygulamada, # ! 4 ve 6 ! 2 değerleri için (2.40) eşitliği ile elde edilen

genelleme sınırlarının kötü performans sergilediği görülmüştür. Bundan dolayı, gerçek

hayat problemlerine ilişkin dağılımları yansıtan # ve 6 sabitlerinin daha küçük

değerleri deneysel olarak seçilebilmektedir (Cherkassky ve Mulier 2007). Örneğin,

uygulama sonuçlarına göre regresyon problemleri için # ! 1 ve 6 ! 1 değerleri ile

genelleme

sınırlarını kullanarak iyi

modeller seçilebilmektedir. Sınıflandırma

problemleri için # ve 6 ’nin en iyi deneysel değerleri bilinmemektedir (Cherkassky ve

Mulier 2007).

En az 1 7 2L olasılık ile deneysel riski minimum yapan ;:, % fonksiyonu için sınır,

29

&% 7 minQ & S

6%

~

6 1 1 ~

(2.41)

biçiminde verilir.

1 7 L güven düzeyi arttıkça (1’e yaklaştıkça), (2.37) ve (2.41) ile verilen sınırlar da

büyür. Çünkü diğer parametreler sabit iken L C 0 iken (2.38)–(2.40) eşitlikleri gereği,

C ∞ olur ve tüm sınırların sağ tarafı (sonsuza doğru) büyür. Bu durumda, sınırların

uygulamada kullanılabilirliği düşer. Burada sezgisel olarak, sonlu sayıda örneklemden

elde edilen herhangi bir (model) tahminin, gelişigüzel yüksek güven düzeyine sahip

olamayacağı düşünülür. Sınırlar tarafından sağlanan doğruluk ile güven düzeyi arasında

genellikle ters yönde bir ilişki vardır. Bunun aksine, diğer parametreler sabit iken

örneklem sayısı arttıkça ise (2.37) ve (2.41) sınırları daha doğru (dar) hale gelecek yani,

C ∞ iken deneysel risk, gerçek riske daha yakın olacaktır. Bundan dolayı

uygulamada bu sınırları kullanmak üzere mantıklı olan yol, güven düzeyini, örneklem

sayısının bir fonksiyonu olarak seçmektir. Böylece, örneklem sayısı küçük olduğunda

güven düzeyi düşük tutulur; örneklem sayısı büyük olduğunda ise güven düzeyi yüksek

tutulur. Vapnik (1995) tarafından özel olarak güven düzeyini belirlemek üzere

geliştirilen kural,

L ! min [

√%

, 1\

(2.42)

biçimindedir. Ayrıca, eşitlik (2.38) incelendiğinde, (2.37) eşitsizliğinin sağ yanındaki

ikinci terim ile ⁄ oranı arasında güçlü bir ilişkinin var olduğu görülecektir. Bu

durumda da iki farklı düzen ortaya çıkar: (1) örneklem sayısının küçük (sonlu) olması

durumu (eğitim veri sayısının, yakınsama fonksiyonlarının VC boyutuna oranının küçük

olduğu zaman (örneğin, ⁄ N 20 ise)) ve (2) büyük örneklem sayısı (⁄ oranının

büyük olduğu zaman). Örneklem sayısının büyük olması halinde eşitsizlik (2.37)’nin

sağ yanındaki ikinci terimin değeri küçülür ve deneysel risk, gerçek riskin bir ölçümü

olarak rahatlıkla kullanılabilir. Böylece Şekil 2.2’den de anlaşılacağı üzere, klasik

(parametrik) istatistiksel yöntemlerin, DRM’ye veya maksimum olabilirlik yöntemine

30

dayalı bir uygulaması gerçekleştirilmiş olur. Bunun aksine, küçük örneklem halinde

ikinci terimin değeri göz ardı edilemez ve bu durumda yakınsama fonksiyonlarının

karmaşıklığının (kapasite), mevcut veriye uyumlu olmasına ihtiyaç vardır. Bu da YRM

tümevarım prensibinin kullanımı ile mümkündür.

2.4.2 Regresyon

Öğrenme

makinesi

tarafından,

sınırlandırılmamış

negatif

olmayan

kayıp

fonksiyonlarının kullanıldığı regresyon fonksiyon tahmini problemleri göz önüne

alınsın. Gerçek fonksiyon üzerine sınırlar bilinmedikçe de bu tip kayıp fonksiyonları

için sonlu sınırlar elde edilemez. Başka bir ifadeyle, küçük bir olasılıkla bile olsa kayıp

fonksiyonunun büyük (sınırlandırılmamış) değerleriyle sonuçlanan çok büyük çıktı

değerleri gözlemlenebilir. Sadece sonlu eğitim verisinden bu olasılığı tahmin etmek de

mümkün değildir. Böylece, öğrenme teorisi, kaybın büyük değerlerinin çok sık ortaya

çıkmadığı sınırlandırılmamış kayıp fonksiyonlarının dağılımları için bazı genel

tanımlamalar sağlar (Vapnik 1995). Bu tanımlama, kaybın büyük değerlerinin gözlenme

olasılığı olarak adlandırılan, dağılımların kuyruk davranışlarını açıklar. Hafif kuyruklu

dağılımlar için ise hızlı bir yakınsama derecesi mümkündür. Bu gibi dağılımlar için

genelleme üzerine sınırlar Teorem 2.5 ile verilir.

Teorem 2.5: En az 1 7 L olasılık ile

& S

Q

(2.43)

(#√~)

eşitsizliği, bütün kayıp fonksiyonları (deneysel riski minimum yapan fonksiyon da

dahil) için eşanlı olarak sağlanır. Burada , (2.38) ile elde edilir ve !

maks, 0’dır. Ayrıca, sabiti, kayıp fonksiyonunun dağılımının kuyruklarına bağlı

olarak belirlenir. Bir regresyon probleminde, büyük örneklem sayısı için 1 7 L güven

düzeyi, (2.42) denklemi ile belirlendiğinde; # ! 1, 6 ! 1 ve ! 1 değerleri için VC

sınırları,

31

& S &=>? 1 7 7 ln

%

6%

#

(2.44)

olarak elde edilir. Burada ! ⁄’dir.

En az 1 7 2L olasılık ile deneysel riski minimum yapan ;:, % fonksiyonu için sınır,

Q Q

Q

√~

S (#

√~)

#

O [% \

(2.45)

biçiminde verilir. Bu sınır deneysel risk ile mümkün en küçük risk arasındaki farkı

tahmin etmek üzere kullanılır (Cherkassky ve Mulier 2007).

2.5 Yapısal Risk Minimizasyonu

Önceki kesimlerde de tartışıldığı gibi DRM tümevarım prensibinin büyük örneklemler

için uygulanması hedeflenir. Bu durumda yani ⁄ oranı büyük olduğunda,

sınıflandırma problemi için (2.37) denklemi, regresyon problemi için (2.43) denklemi

ile verilen sınırda ¡ 0 olacak ve deneysel risk, gerçek riske yaklaşacaktır. Böylece

deneysel riskin küçük bir değeri, küçük gerçek riski garanti edecektir. Ancak ⁄

oranının küçük olması (örneğin, ⁄ N 20) halinde (2.37) denkleminin sağ yanındaki

tüm terimlerin veya (2.43) denkleminin pay ve payda kısımlarının minimum yapılması

gerekmektedir. (2.37) denkleminin sağ yanındaki ilk terim (deneysel risk), fonksiyonlar

kümesinden seçilmiş belirli bir fonksiyona bağlı iken; ikinci terim esas olarak

fonksiyonlar kümesinin VC boyutuna bağlıdır. Benzer bir biçimde; regresyon

problemleri için (2.43) ile verilen sınırda pay kısmı, özel bir fonksiyona; payda kısmı

ise fonksiyonlar kümesinin VC boyutuna bağlıdır. (2.37) ve (2.43)’de riskin sınırlarını

tüm terimler üzerinden minimum yapmak için VC boyutunun bir kontrol değişkeni

olarak belirlenmesi gerekmektedir. Bir başka ifade ile problem, verilen bir eğitim veri

seti için optimum kapasiteye (VC boyutuna) sahip olan fonksiyonlar kümesini

belirlemektir. Birçok uygulama probleminde, gerçek model karmaşıklığı bilinmeyip de

32

sadece veri seti mevcut olduğunda küçük örneklem tahmin problemi ile karşılaşılır.

Bunun aksine; DRM tümevarım prensibine dayalı parametrik yöntemler, gerçek

modelin, fonksiyonlar kümesi tarafından içerildiği varsayımı altında; fonksiyonlar

kümesinin bilinen bir sabit karmaşıklığını (parametre sayısı gibi) kullanır. Bu

parametrik yaklaşım, yukarıdaki varsayımın sağlanması ve gözlem sayısının (⁄

oranının) büyük olması halinde doğrulanır (Cherkassky ve Mulier 2007).

Yapısal risk minimizasyonu (YRM) olarak adlandırılan tümevarım prensibi, sonlu

örneklemler için optimum model karmaşıklığını belirlemek üzere biçimsel bir

mekanizma sağlar. YRM esasında sınıflandırma problemleri için önerilmiş ve

uygulanmıştır fakat herhangi bir öğrenme problemi için de uygulanabilir. ;:, , Ω fonksiyonlar kümesi ile gösterilmek üzere; , birbirini içeren _ ! .;:, , Ω¢ 1 altkümelerinden (elemanlarından) oluşan bir yapı öyle ki,

# £ 6 £ ¤ £ % ¤

(2.46)

olsun ve her bir _ elemanı da sonlu bir _ , VC boyutu ile belirlensin. Buna göre YRM,

elemanların karmaşıklığına (VC boyutuna) göre sıralamalarını, Şekil 2.5’de verildiği

gibi belirler.

Ayrıca _ elemanı tarafından içerilen ;:, , Ω¢ fonksiyonları ya sınırlı olmalı ya

da (eğer sınırsız ise) risk fonksiyonunun sınırsız ve kontrolsüz büyümemesini temin

etmek üzere bazı genel şartları sağlamalıdır (Vapnik 1995).

# S 6 S ¤ S _ S ¤

#

6 ¤

_ ¤

Şekil 2.5 Fonksiyonlar kümesinin yapısı

33

YRM’ye göre sonlu veri ile öğrenme probleminin çözümü, yakınsama fonksiyonlarının

bir kümesi üzerinde yapının, öncül bilgi olarak tanımlanmasını gerektirmektedir. Daha

sonra da verilen bir veri seti için optimum model tahmini,

Adım 1. Optimum karmaşıklığa sahip olan yapıdan eleman seçimi,

Adım 2. Adım 1’de seçilen elemanlar kullanılarak model tahmini

biçiminde verilen iki adım ile gerçekleştirilir. Burada istatistiksel yöntem olarak; birinci

adım model seçimine, ikinci adım ise parametre tahminine karşılık gelir.

(2.37) ve (2.43) ile verilen VC sınırlarını minimum yapmak üzere iki geliştirici YRM

uygulamasına öncülük eden stratejiler,

1. Model karmaşıklığı (VC boyutu) sabit tutulur ve deneysel hata terimi minimum

yapılır,

2. Deneysel hata sabit (küçük) tutulur ve VC boyutu minimum yapılır

biçiminde verilir (Cherkassky ve Mulier 2007). İlk YRM stratejisi şöyle açıklanır:

Verilen bir :# , :6 , … , :% eğitim verisi için YRM prensibi, _ elemanından alınan

fonksiyonlar için deneysel riski minimum yapan ;_ :, % fonksiyonunu belirler. Daha

sonra, _ yapısının her bir elemanı için garanti edilmiş risk, sınıflandırma

problemlerinde (2.37) eşitsizliğinin veya regresyon problemlerinde (2.43) eşitsizliğinin

sağ yanı ile belirli sınırların kullanılmasıyla bulunur. Son olarak ise minimum garanti

edilmiş riski veren elemanın optimum yapısı, ¥?a seçilir. ¥?a altkümesi, mevcut bir

veri seti için optimum karmaşıklığa (VC boyutuna) sahip olan bir fonksiyonlar

kümesidir.

YRM prensibi esasında yakınsama fonksiyonlarının karmaşıklığı ile eğitim veri setine

uyumun kalitesi arasındaki değişimin çözümlemesini gerçekleştirir. Şekil 2.6’da

görüldüğü gibi karmaşıklık (¦ altküme indeksi) arttıkça deneysel riskin minimumu

azalır (veriye uyumun kalitesi artar). Böylece, (2.37) denklemindeki ikinci terimin

34

değeri artar. Benzer biçimde, regresyon problemleri için artan karmaşıklık ile (2.43)

eşitsizliğinin pay kısmındaki terim (deneysel risk) değeri azalır. Bu durumda da payda

küçük (sıfıra yakın) hale gelir. YRM, gerçek risk üzerinde minimum garanti edilmiş

riski veren yapının optimum elemanını seçer (Luxburg ve Schölkopf 2011).

Sınıflandırma hatası

Aşağı uyum

Aşırı uyum

Gerçek risk

Güven aralığı

Deneysel risk

#

r

_

Şekil 2.6 değerinin ( sabit) bir fonksiyonu olarak gerçek (beklenen) risk ve deneysel

risk üzerine sınırlar

35

3. DESTEK VEKTÖR MAKİNELERİ

Destek vektör makineleri (DVM), sınırlı sayıda öğrenme örüntüsü üzerinden iyi bir

genelleme düzeyi elde etmek amacıyla yapısal risk minimizasyonu (YRM) tümevarım

prensibini uygulayan bir öğrenme makinesidir. YRM, deneysel riski ve VC (Vapnik–

Chervonenkis) boyutunu minimum yapmak üzere eşanlı girişimlerden oluşmaktadır.

Teori esasında ayrılabilir ikili sınıflandırma problemi temelinde, Vapnik ve çalışma

arkadaşları tarafından AT & T Bell Laboratuarlarında geliştirilmiştir. DVM, karmaşık

veri setlerinde, çözümlemesi zor örüntülerin tanımlanmasında kullanışlı bir öğrenme

algoritmasını uygulamaktadır. Algoritma, önceden gözlenmemiş verilerin sınıflandırma

kestirimi

için

örneklerden

ayırt

edebilen

bir

sınıflandırma

öğrenmesini

gerçekleştirmektedir.

Bir fonksiyonlar kümesinin VC boyutu, bu fonksiyonlar kümesi tarafından

parçalanabilen en büyük veri setinin boyutudur. §% kümesinden .0, 11’e veya .71, 11’e

tanımlı , fonksiyonlar kümesi göz önüne alınsın. Bu fonksiyonlar, veri

noktalarını iki sınıftan birine eşleyen gösterge fonksiyonları olarak adlandırılır. §% ’de

tanımlı tane nokta ele alındığında bu noktalardan her biri 0 veya 1 sınıflarından birine

rasgele atanabilir. Buna göre tane nokta 2 farklı yol ile etiketlenebilir. Örneğin, §6

düzleminde tanımlı üç nokta için ayırıcı hiperdüzlem ile 8 mümkün etiketleme Şekil

3.1’de gösterilmiştir. Buna göre, §6 düzleminde yönlendirilmiş doğrular kümesinin VC

boyutunun 3’e eşit olduğu söylenilebilir.

Bölüm 2’de sınıflandırma problemlerinde sonlu örneklem ile öğrenme için VC

genelleme sınırı (2.37) denklemi ile verilmişti. Bu eşitsizliğin sağ yanındaki ikinci

terim, temel olarak VC boyutuna (veya ⁄ oranına) bağlı iken, birinci terim (deneysel

risk), parametresine bağlıdır. YRM tümevarım prensibi, verilen sayıda eğitim

örneklemi için (2.37) denkleminin sağ yanını minimum yapmak amacıyla tahmin